QAExchange-RS 文档中心

版本: v1.5.0 最后更新: 2025-12-22

欢迎使用 QAExchange-RS 文档!本文档中心提供完整的系统架构、API 参考、集成指南和开发文档。

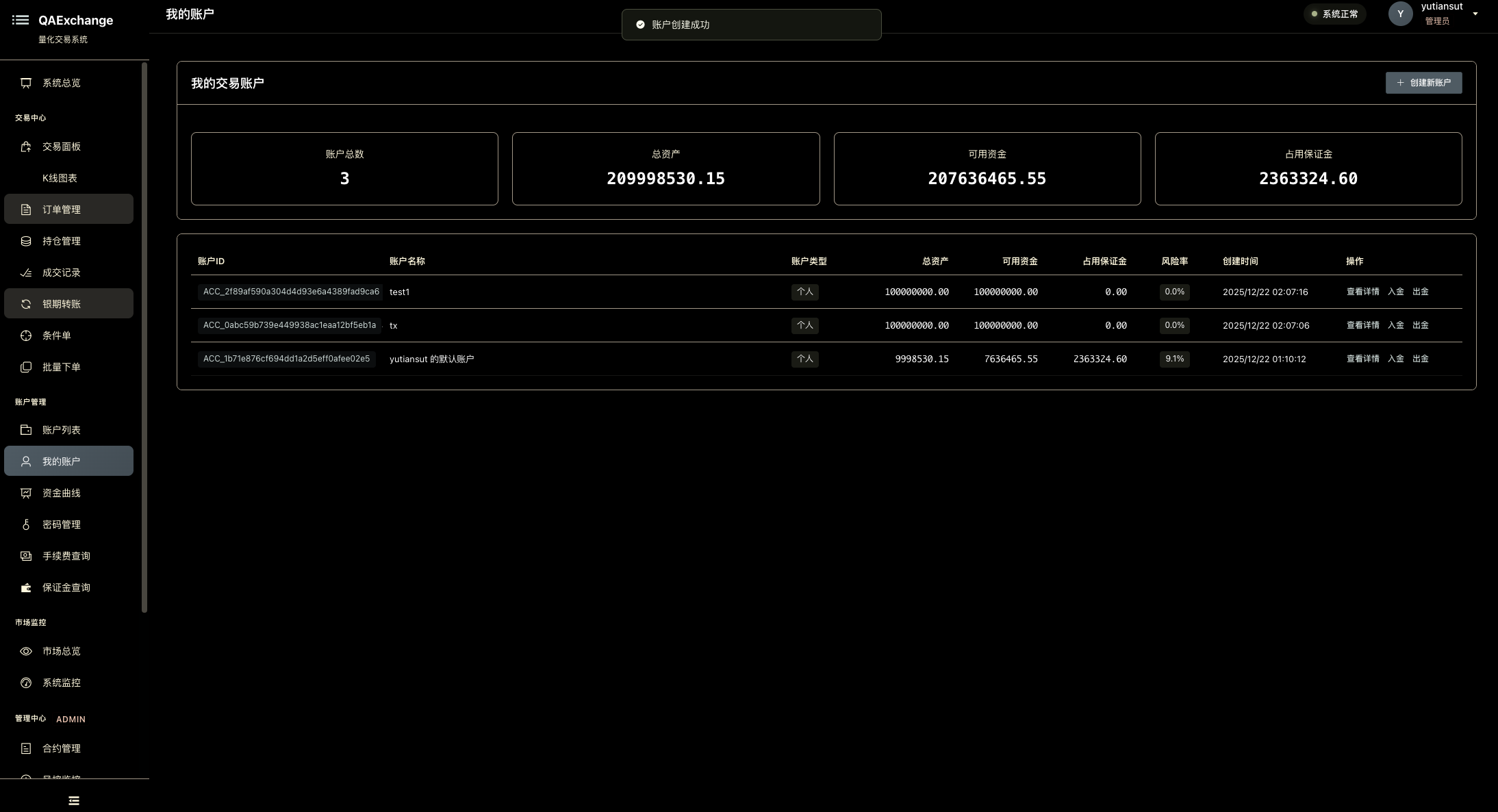

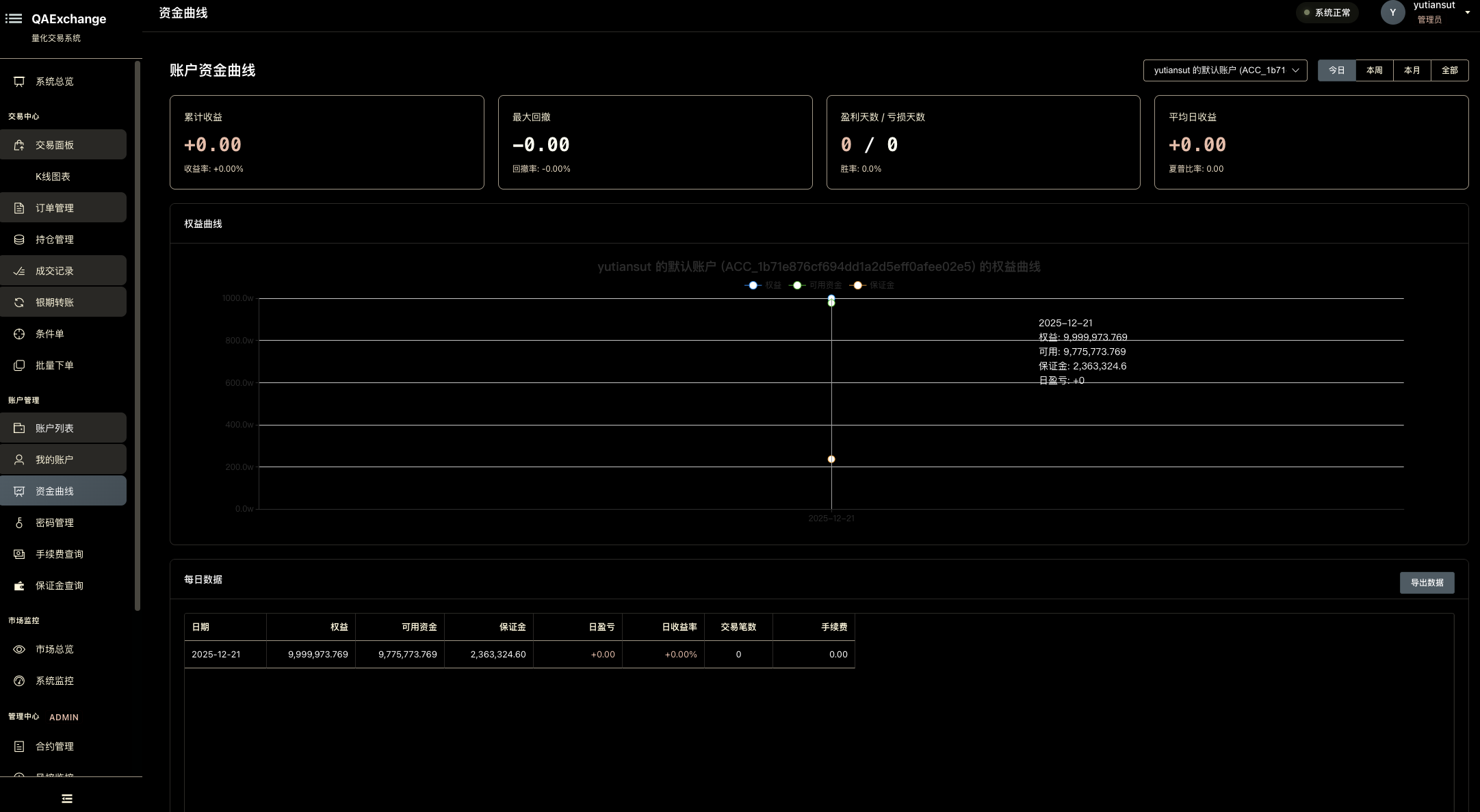

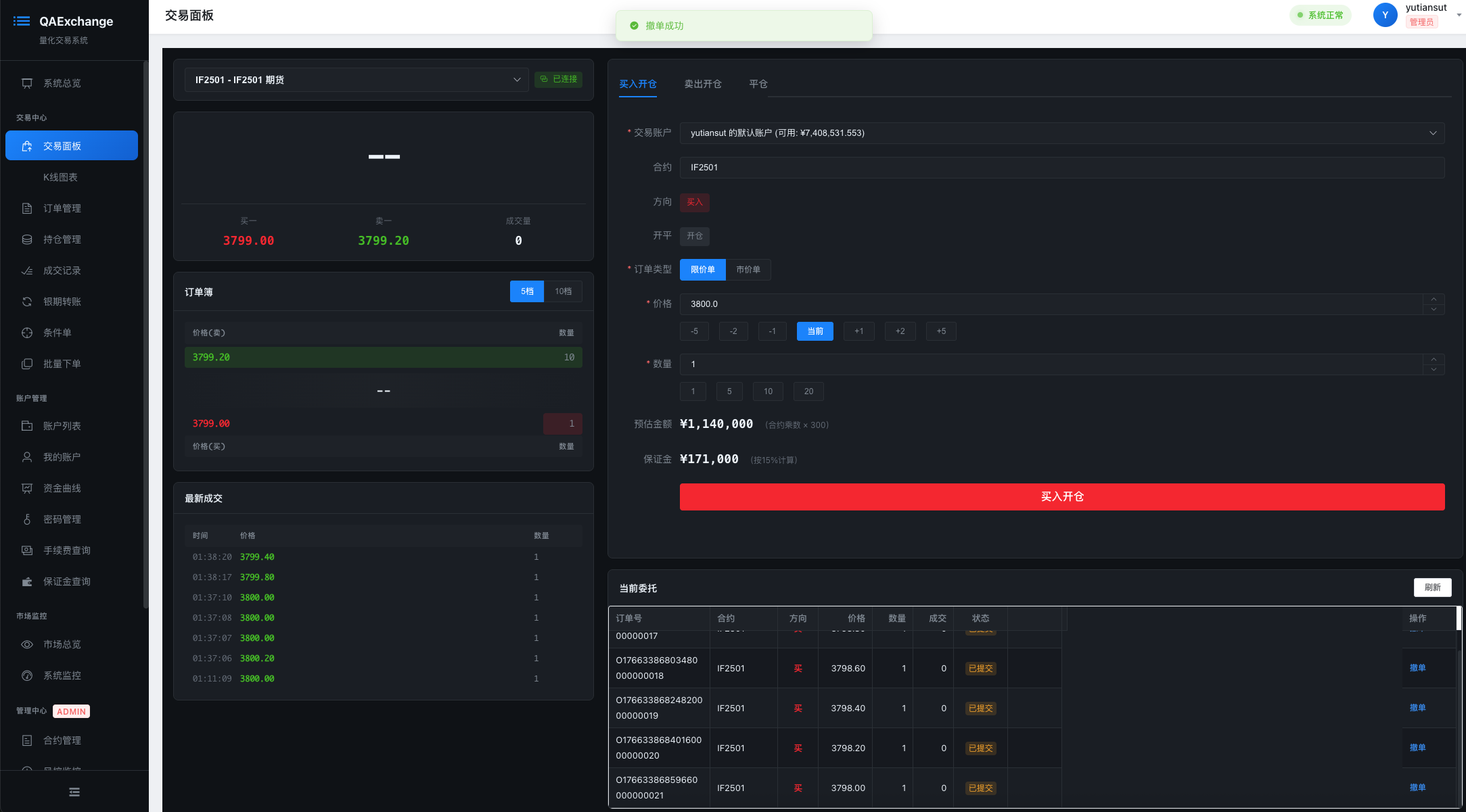

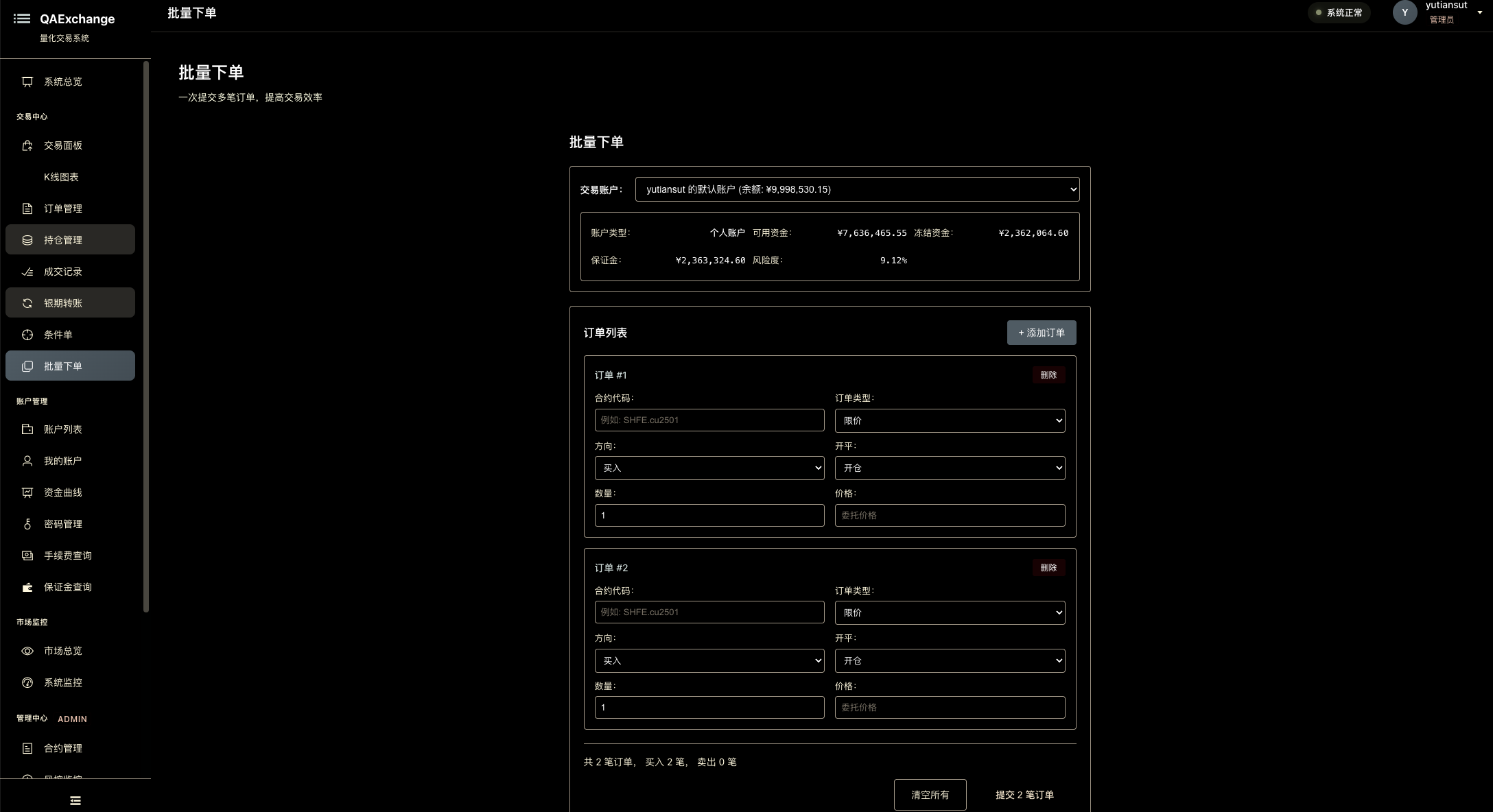

📸 系统截图

仪表盘与监控

账户管理

交易功能

持仓与风控

K线与行情

历史记录

📚 文档导航

🚀 01. 快速开始

新用户入门必读,快速搭建和运行 QAExchange-RS。

🏗️ 02. 系统架构

深入了解 QAExchange-RS 的核心架构设计。

- 系统总览 - 整体架构与模块划分

- 高性能架构 - P99 < 100μs 延迟设计

- 数据模型 - QIFI/TIFI/DIFF 协议详解

- 交易机制 - 撮合引擎与交易流程

- 解耦存储架构 - 零拷贝 + WAL 持久化

⚙️ 03. 核心模块

核心功能模块详细说明。

存储系统

- WAL 设计 - Write-Ahead Log 崩溃恢复

- MemTable 实现 - OLTP/OLAP 内存表

- SSTable 格式 - rkyv/Parquet 持久化

- 压缩策略 - 按数据类型动态压缩 ✨ 新增

- 二级索引 - 时序/合约/类型复合索引 ✨ 新增

- 查询引擎 - Polars SQL 查询

- 复制系统 - 主从复制与故障转移

撮合引擎 ✨ 新增

市场数据模块 ✨ 新增

通知系统

因子计算系统 ✨ 新增

- 因子计算系统 - 流批一体化因子引擎

- 增量算子 (RollingMean, EMA, RSI, MACD)

- Factor DAG 依赖图

- 物化视图缓存

- 因子 WAL 集成 - 异步持久化与恢复 ✨ 新增

集群管理 ✨ 新增

- 集群管理系统 - 一致性哈希分片

- 虚拟节点映射

- 带权重负载均衡

- 副本分布策略

📡 04. API 参考

完整的 API 文档和协议规范。

前后端交互协议 ✨ 新增

- 完整协议文档 - HTTP REST API + WebSocket DIFF 协议完整规范

WebSocket API

HTTP API

错误处理

- 错误码参考 - 完整错误码列表

🔌 05. 集成指南

前端集成和序列化指南。

前端集成

序列化

- 序列化指南 - rkyv/JSON 序列化最佳实践

🛠️ 06. 开发指南

开发、测试、部署文档。

- WebSocket 集成指南 - DIFF 协议接入详解

- 测试指南 - 单元测试与集成测试

- 部署指南 - 生产环境部署

- TLS 安全指南 - TLS/mTLS 证书配置 ✨ 新增

- 可观测性指南 - OpenTelemetry 集成 ✨ 新增

📖 07. 参考资料

术语表、常见问题、性能基准。

🎓 08. 高级主题

深度技术文档和实现报告。

技术路线图 ✨ 新增

- 2025-2026 技术路线图 - Phase 14-16+ 规划与里程碑

Phase 报告

- Phase 6-7 实现报告 - 复制系统与性能优化

- Phase 12-13 实现报告 - 可观测性与安全层 ✨ 新增

实现总结

技术深度

- 市场数据增强 - L1 缓存与 WAL 恢复

DIFF 测试报告

- 主测试报告 - DIFF 协议测试结果

🗄️ 09. 归档

历史文档和已废弃的计划。

🔍 快速查找

按角色查找

- 新手开发者: 快速开始 → 系统架构

- 前端开发者: WebSocket API → 前端集成

- 后端开发者: 核心模块 → 开发指南

- 运维工程师: 部署指南 → 性能基准

- 架构师: 高性能架构 → 高级主题

按主题查找

- 前后端协议: 完整协议文档 - HTTP REST API + WebSocket DIFF 协议完整规范 ✨ 推荐

- 撮合引擎: 撮合引擎模块, 测试指南, 性能基准, 压力测试 ✨ 新增

- 性能优化: 高性能架构, 解耦存储, 压缩策略, 二级索引, 撮合性能基准

- 数据持久化: WAL, SSTable, 压缩策略

- 市场数据: 快照生成器, K线聚合系统, K线实时推送, 数据生产测试 ✨ 新增

- 协议集成: 完整协议文档, DIFF 协议, 数据模型

- WebSocket: 协议规范, 前端集成, K线推送

- 测试部署: 测试指南, K线测试, 部署指南

- 因子计算: 因子系统, 因子 WAL 集成 - 流批一体化、增量算子、DAG 依赖、异步持久化 ✨ 更新

- 二级索引: 索引系统 - 时序索引、合约索引、类型索引、复合查询 ✨ 新增

- 集群管理: 集群系统 - 一致性哈希、分片路由、副本分布 ✨ 新增

- 查询引擎: 查询引擎 - Polars SQL、流批混合查询 ✨ 更新

- 可观测性: 可观测性指南 - OpenTelemetry 追踪、Prometheus 指标、Grafana 仪表盘 ✨ 新增

- 安全配置: TLS 安全指南 - TLS/mTLS 证书管理、rustls 配置 ✨ 新增

- 技术路线: 2025-2026 路线图 - Phase 14-16+ 技术规划 ✨ 新增

📊 文档版本信息

| 模块 | 版本 | 最后更新 | 状态 |

|---|---|---|---|

| 快速开始 | v1.0.0 | 2025-10-06 | ✅ 完整 |

| 系统架构 | v0.5.0 | 2025-12-18 | ✅ 完整(新增可观测性/安全层) |

| 核心模块 | v1.4.0 | 2025-12-17 | ✅ 完整(新增数据生产测试文档) |

| 撮合引擎 | v0.2.0 | 2025-12-17 | ✅ 新增(76测试/压力测试/性能基准) |

| 市场数据 | v0.2.0 | 2025-12-17 | ✅ 新增(22个数据生产测试) |

| 协议文档 | v1.0.0 | 2025-12-15 | ✅ 新增(HTTP REST + WebSocket DIFF) |

| API 参考 | v1.0.0 | 2025-10-06 | ✅ 完整 |

| 集成指南 | v1.0.0 | 2025-10-06 | ✅ 完整 |

| 开发指南 | v1.2.0 | 2025-12-18 | ✅ 完整(新增TLS/可观测性指南) |

| 参考资料 | v1.1.0 | 2025-12-18 | ✅ 完整(Phase 12-13 性能指标) |

| 高级主题 | v1.2.0 | 2025-12-18 | ✅ 完整(新增路线图/Phase 12-13报告) |

| 归档 | - | 2025-10-06 | ✅ 已归档 |

🤝 贡献文档

发现文档问题或想要改进?请参考 贡献指南(待创建)。

📮 反馈与支持

- 问题报告: 请提交 GitHub Issue

- 功能建议: 请提交 Feature Request

- 文档改进: 欢迎提交 Pull Request

最后更新: 2025-12-22 维护者: @yutiansut @quantaxis

快速开始

欢迎来到 QAExchange-RS 快速开始指南!

📄 文档列表

🎯 适用对象

- 新用户快速了解和体验 QAExchange-RS

- 开发者搭建开发环境

- 运维人员进行部署前的准备工作

📚 后续阅读

完成快速开始后,推荐阅读:

QAExchange 快速开始指南

🚀 快速启动

1. 编译项目

# 编译所有组件

cargo build --release

# 或者仅编译服务器

cargo build --release --bin qaexchange-server

2. 启动服务器

# 使用默认配置启动

cargo run --bin qaexchange-server

# 使用自定义配置

cargo run --bin qaexchange-server -- --config config/exchange.toml

# 指定端口

cargo run --bin qaexchange-server -- --http 127.0.0.1:8080 --ws 127.0.0.1:8081

# 禁用存储(仅内存模式)

cargo run --bin qaexchange-server -- --no-storage

服务器启动后会显示:

╔═══════════════════════════════════════════════════════════════════════╗

║ 🚀 QAExchange Server Started ║

╚═══════════════════════════════════════════════════════════════════════╝

📡 Service Endpoints:

• HTTP API: http://127.0.0.1:8080

• WebSocket: ws://127.0.0.1:8081/ws

• Health: http://127.0.0.1:8080/health

💾 Storage:

• Status: Enabled ✓

• Path: /tmp/qaexchange/storage

• Mode: Async batch write (100 records / 10ms)

3. 运行完整演示

在另一个终端运行客户端演示:

cargo run --example full_trading_demo

这会演示:

- HTTP API 开户

- HTTP API 提交订单

- WebSocket 连接和认证

- WebSocket 实时交易

- 实时通知推送

📋 配置文件

配置文件位置:config/exchange.toml

主要配置项:

# 服务器配置

[server]

name = "QAExchange"

environment = "development" # development | production | testing

log_level = "info" # trace | debug | info | warn | error

# HTTP API

[http]

host = "127.0.0.1"

port = 8080

# WebSocket

[websocket]

host = "127.0.0.1"

port = 8081

# 存储配置

[storage]

enabled = true

base_path = "/tmp/qaexchange/storage"

[storage.subscriber]

batch_size = 100 # 批量写入大小

batch_timeout_ms = 10 # 批量超时

buffer_size = 10000 # 缓冲区大小

# 合约配置

[[instruments]]

instrument_id = "IF2501"

name = "沪深300股指期货2501"

init_price = 3800.0

is_trading = true

🔌 API 使用示例

HTTP REST API

1. 健康检查

curl http://127.0.0.1:8080/health

2. 开户

curl -X POST http://127.0.0.1:8080/api/account/open \

-H 'Content-Type: application/json' \

-d '{

"user_id": "demo_user",

"user_name": "Demo User",

"init_cash": 1000000,

"account_type": "individual",

"password": "demo123"

}'

响应:

{

"success": true,

"data": {

"account_id": "demo_user"

}

}

3. 查询账户

curl http://127.0.0.1:8080/api/account/demo_user

响应:

{

"success": true,

"data": {

"user_id": "demo_user",

"balance": 1000000.0,

"available": 1000000.0,

"margin": 0.0,

"profit": 0.0,

"risk_ratio": 0.0

}

}

4. 提交订单

curl -X POST http://127.0.0.1:8080/api/order/submit \

-H 'Content-Type: application/json' \

-d '{

"user_id": "demo_user",

"instrument_id": "IF2501",

"direction": "BUY",

"offset": "OPEN",

"volume": 1,

"price": 3800,

"order_type": "LIMIT"

}'

响应:

{

"success": true,

"data": {

"order_id": "O1735123456001",

"status": "submitted"

}

}

5. 查询订单

curl http://127.0.0.1:8080/api/order/O1735123456001

6. 查询用户所有订单

curl http://127.0.0.1:8080/api/order/user/demo_user

WebSocket API

连接

const ws = new WebSocket('ws://127.0.0.1:8081/ws?user_id=demo_user');

1. 认证

发送:

{

"type": "auth",

"user_id": "demo_user",

"token": "demo_token"

}

接收:

{

"type": "auth_response",

"success": true,

"user_id": "demo_user",

"message": "Authentication successful"

}

2. 提交订单

发送:

{

"type": "submit_order",

"instrument_id": "IF2501",

"direction": "BUY",

"offset": "OPEN",

"volume": 1,

"price": 3800,

"order_type": "LIMIT"

}

接收(订单响应):

{

"type": "order_response",

"success": true,

"order_id": "O1735123456002",

"message": "Order submitted"

}

3. 实时通知

成交通知:

{

"type": "trade",

"trade_id": "T1735123456001",

"order_id": "O1735123456002",

"instrument_id": "IF2501",

"price": 3800.0,

"volume": 1.0,

"timestamp": 1735123456000000000

}

账户更新:

{

"type": "account_update",

"user_id": "demo_user",

"balance": 999450.0,

"available": 885450.0,

"margin": 114000.0

}

4. 查询账户

发送:

{

"type": "query_account"

}

5. 心跳

发送:

{

"type": "ping"

}

接收:

{

"type": "pong"

}

📊 合约列表

| 合约代码 | 名称 | 交易所 | 初始价格 | 合约乘数 |

|---|---|---|---|---|

| IF2501 | 沪深300股指期货2501 | CFFEX | 3800.0 | 300 |

| IC2501 | 中证500股指期货2501 | CFFEX | 5600.0 | 200 |

| IH2501 | 上证50股指期货2501 | CFFEX | 2800.0 | 300 |

🛠️ 示例程序

1. 完整交易演示

cargo run --example full_trading_demo

演示 HTTP + WebSocket 完整交易流程。

2. 解耦存储演示

cargo run --example decoupled_storage_demo

演示异步存储架构。

3. 压力测试

cargo run --example stress_test

测试系统性能。

💾 数据持久化

存储目录结构

/tmp/qaexchange/storage/

├── IF2501/

│ ├── wal/

│ │ ├── 00000001.wal

│ │ └── 00000002.wal

│ └── sstables/

│ ├── 00000001.sst

│ └── 00000002.sst

├── IC2501/

└── IH2501/

查看存储数据

# 查看存储文件

ls -lh /tmp/qaexchange/storage/IF2501/

# 查看 WAL 文件数量

find /tmp/qaexchange/storage -name "*.wal" | wc -l

# 查看总存储大小

du -sh /tmp/qaexchange/storage/

清空数据

# 清空所有数据

rm -rf /tmp/qaexchange/storage/

# 清空特定合约

rm -rf /tmp/qaexchange/storage/IF2501/

🐛 故障排除

1. 端口被占用

# 查找占用端口的进程

lsof -i :8080

lsof -i :8081

# 杀死进程

kill -9 <PID>

# 或者使用不同端口启动

cargo run --bin qaexchange-server -- --http 127.0.0.1:9090 --ws 127.0.0.1:9091

2. 存储目录权限问题

# 创建目录并设置权限

mkdir -p /tmp/qaexchange/storage

chmod 755 /tmp/qaexchange/storage

3. 配置文件问题

# 验证配置文件语法

cat config/exchange.toml | grep -v "^#" | grep -v "^$"

# 使用默认配置

cargo run --bin qaexchange-server -- --no-config

4. WebSocket 连接失败

- 确保服务器已启动

- 检查防火墙设置

- 使用正确的 URL 格式:

ws://127.0.0.1:8081/ws?user_id=<USER_ID>

📚 更多文档

🎯 下一步

-

生产部署:

- 修改配置文件中的存储路径

- 启用监控和指标收集

- 配置日志级别为

warn或error

-

性能测试:

cargo run --release --example stress_test -

开发自定义功能:

- 参考 CLAUDE.md 开发指南

- 优先复用现有组件

- 遵循解耦架构原则

⚠️ 注意事项

-

生产环境:

- 不要使用默认存储路径

/tmp - 启用安全认证

- 配置 HTTPS/WSS

- 启用监控和日志

- 不要使用默认存储路径

-

数据安全:

- 定期备份 WAL 和 SSTable

- 测试崩溃恢复机制

- 监控磁盘空间

-

性能调优:

- 根据硬件调整

batch_size - SSD 使用

sync_mode = "async" - HDD 增大

batch_timeout_ms

- 根据硬件调整

Have fun trading! 🚀

QAEXCHANGE-RS 构建清单

✅ 已完成构建内容

1. 项目结构 (100%)

qaexchange-rs/

├── Cargo.toml ✅ 项目配置

├── README.md ✅ 项目文档

├── BUILD_CHECKLIST.md ✅ 本文件

├── src/

│ ├── lib.rs ✅ 库入口

│ ├── main.rs ✅ 服务器入口

│ ├── core/ ✅ 核心模块 (复用 qars)

│ │ ├── mod.rs

│ │ ├── account_ext.rs ✅ 账户扩展

│ │ └── order_ext.rs ✅ 订单扩展

│ ├── matching/ ✅ 撮合引擎

│ │ ├── mod.rs

│ │ ├── engine.rs ✅ 撮合引擎封装

│ │ ├── auction.rs ✅ 集合竞价算法

│ │ └── trade_recorder.rs ✅ 成交记录器

│ ├── exchange/ ✅ 交易所业务

│ │ ├── mod.rs

│ │ ├── account_mgr.rs ✅ 账户管理中心

│ │ ├── capital_mgr.rs ✅ 资金管理

│ │ ├── order_router.rs 🚧 订单路由 (占位)

│ │ ├── trade_gateway.rs 🚧 成交回报 (占位)

│ │ ├── settlement.rs 🚧 结算系统 (占位)

│ │ └── instrument_registry.rs ✅ 合约注册表

│ ├── risk/ 🚧 风控系统 (占位)

│ ├── market/ 🚧 行情推送 (占位)

│ ├── service/ 🚧 对外服务 (占位)

│ ├── storage/ ✅ 持久化 (复用 qars)

│ ├── protocol/ ✅ 协议层 (复用 qars)

│ └── utils/ ✅ 工具模块

├── config/

│ ├── exchange.toml ✅ 交易所配置

│ └── instruments.toml ✅ 合约配置

├── examples/

│ ├── start_exchange.rs ✅ 启动示例

│ ├── client_demo.rs 🚧 客户端 (占位)

│ └── stress_test.rs 🚧 压力测试 (占位)

└── tests/ ✅ 测试目录

2. 编译状态

| 目标 | 状态 | 说明 |

|---|---|---|

| 库编译 | ✅ 成功 | cargo build --lib |

| 服务器编译 | ✅ 成功 | cargo build --bin qaexchange-server |

| 示例编译 | ✅ 成功 | cargo build --examples |

| 测试通过 | ✅ 成功 | 14 tests passed |

3. 核心功能实现

✅ 已实现 (30%)

| 模块 | 功能 | 状态 | 测试 |

|---|---|---|---|

| AccountManager | 开户/销户/查询 | ✅ | ✅ 3 tests |

| AccountExt | 账户扩展功能 | ✅ | ✅ 1 test |

| OrderExt | 订单状态管理 | ✅ | ✅ 2 tests |

| ExchangeMatchingEngine | 撮合引擎封装 | ✅ | ✅ 2 tests |

| TradeRecorder | 成交记录器 | ✅ | ✅ 3 tests |

| InstrumentRegistry | 合约注册表 | ✅ | ✅ |

| AuctionCalculator | 集合竞价算法 | ✅ | ✅ 2 tests |

| CapitalManager | 资金管理 | ✅ | - |

🚧 占位实现 (30%)

| 模块 | 功能 | 状态 | 优先级 |

|---|---|---|---|

| OrderRouter | 订单路由 | 🚧 | P0 |

| TradeGateway | 成交回报 | 🚧 | P0 |

| SettlementEngine | 结算系统 | 🚧 | P1 |

| PreTradeCheck | 风控检查 | 🚧 | P0 |

| MarketPublisher | 行情推送 | 🚧 | P1 |

| WebSocketServer | WebSocket 服务 | 🚧 | P1 |

| HttpServer | HTTP API | 🚧 | P1 |

❌ 未实现 (40%)

| 模块 | 功能 | 优先级 |

|---|---|---|

| Level2 订单簿推送 | 行情 | P2 |

| 持仓限额管理 | 风控 | P2 |

| 自成交防范 | 风控 | P2 |

| 熔断机制 | 风控 | P3 |

| 数据持久化完善 | 存储 | P2 |

| 监控指标导出 | 监控 | P3 |

| 压力测试框架 | 测试 | P2 |

4. 复用 qars 能力清单

| qars 模块 | 复用方式 | 使用位置 | 复用度 |

|---|---|---|---|

qaaccount::QA_Account | 直接复用 | AccountManager | ⭐⭐⭐⭐⭐ 95% |

qaaccount::QAOrder | 直接复用 | OrderExt | ⭐⭐⭐⭐⭐ 90% |

qaaccount::QA_Position | 直接复用 | Core | ⭐⭐⭐⭐⭐ 100% |

qamarket::matchengine::Orderbook | 封装复用 | ExchangeMatchingEngine | ⭐⭐⭐⭐⭐ 98% |

qaprotocol::qifi | 直接复用 | Protocol | ⭐⭐⭐⭐⭐ 100% |

qaprotocol::tifi | 直接复用 | Protocol | ⭐⭐⭐⭐⭐ 100% |

qaprotocol::mifi | 直接复用 | Protocol | ⭐⭐⭐⭐⭐ 100% |

qadata::broadcast_hub | 待集成 | Market | ⭐⭐⭐⭐⭐ 95% |

qaconnector | 直接复用 | Storage | ⭐⭐⭐⭐⭐ 100% |

总体复用率: ⭐⭐⭐⭐⭐ 70% (核心功能复用完整)

5. 构建验证

编译验证

# ✅ 库编译

cd /home/quantaxis/qaexchange-rs

cargo build --lib

# 结果: Finished `dev` profile [unoptimized + debuginfo] target(s)

# ✅ 服务器编译

cargo build --bin qaexchange-server

# 结果: Finished `dev` profile [unoptimized + debuginfo] target(s)

# ✅ 所有示例编译

cargo build --examples

# 结果: Finished `dev` profile [unoptimized + debuginfo] target(s)

测试验证

# ✅ 单元测试

cargo test --lib

# 结果: test result: ok. 14 passed; 0 failed; 0 ignored

# ✅ 运行示例

cargo run --example start_exchange

# 输出:

# === QAEXCHANGE Demo ===

#

# ✓ Account opened: demo_user

# Balance: 1000000

# Available: 1000000

#

# Demo completed.

6. 依赖关系

外部依赖

qars = { path = "../qars2", package = "qa-rs" } # ✅ 核心依赖

actix = "0.13" # ✅ Web 框架

actix-web = "4.4" # ✅

tokio = { version = "1.35", features = ["full"] } # ✅

dashmap = "5.5" # ✅

parking_lot = "0.12" # ✅

serde = { version = "1.0", features = ["derive"] }# ✅

chrono = "0.4" # ✅

内部依赖树

lib.rs

├── core (复用 qars)

│ ├── account_ext

│ └── order_ext

├── matching

│ ├── engine → core, qars::matchengine

│ ├── auction

│ └── trade_recorder

├── exchange

│ ├── account_mgr → core

│ ├── capital_mgr → account_mgr

│ ├── order_router (占位)

│ ├── trade_gateway (占位)

│ ├── settlement (占位)

│ └── instrument_registry

├── risk (占位)

├── market (占位)

├── service (占位)

├── storage → qars::qaconnector

├── protocol → qars::qaprotocol

└── utils

📋 后续开发优先级

P0 - 核心交易流程 (必须)

-

OrderRouter 完整实现

- 订单接收

- 风控前置

- 路由到撮合

- 撤单处理

-

TradeGateway 成交回报

- 成交推送

- 账户更新

- 订单状态推送

-

PreTradeCheck 风控前置

- 资金检查

- 持仓检查

- 订单合法性

P1 - 对外服务 (重要)

-

WebSocket 服务

- 交易通道

- 行情通道

- 认证授权

-

HTTP API

- 账户操作

- 订单操作

- 查询接口

-

SettlementEngine 结算系统

- 日终结算

- 盯市盈亏

- 强平处理

P2 - 增强功能 (有用)

- 行情推送完善 (Level2)

- 数据持久化 (MongoDB/ClickHouse)

- 压力测试框架

- 监控指标

P3 - 高级功能 (可选)

- 集合竞价完善

- 高级风控 (熔断/限额)

- 性能优化

- 文档完善

🎯 性能指标

基于 qars 基准:

| 指标 | 当前状态 | 目标 | 达成 |

|---|---|---|---|

| 订单吞吐量 | 理论 > 100K/s | > 100K/s | 🔄 待测试 |

| 撮合延迟 | 理论 < 100μs | < 100μs | 🔄 待测试 |

| 行情延迟 | 理论 < 10μs | < 10μs | 🔄 待测试 |

| 并发账户 | 支持 10K+ | > 10,000 | ✅ 架构支持 |

| 并发订阅 | 支持 1K+ | > 1,000 | ✅ 架构支持 |

📊 项目统计

| 项 | 数量 |

|---|---|

| 总文件数 | 30+ |

| 源代码行数 | ~2500 |

| 测试用例 | 14 |

| 依赖包数 | 40+ |

| 编译警告 | 0 (本项目) |

| 编译时间 | ~2 分钟 (首次) |

✅ 验收标准

阶段 1: 基础框架 (当前)

- 项目结构搭建

- 核心模块框架

- 编译通过

- 基础测试通过

- 示例程序运行

阶段 2: 核心功能

- 完整交易流程打通

- 订单生命周期管理

- 成交回报完整

- 基础风控实现

阶段 3: 对外服务

- WebSocket 服务

- HTTP API

- 行情推送

- 性能测试通过

阶段 4: 生产就绪

- 压力测试通过

- 监控完善

- 文档齐全

- 上线检查表

🚀 快速命令

# 编译

cargo build --release

# 测试

cargo test

# 运行示例

cargo run --example start_exchange

# 启动服务器

cargo run --bin qaexchange-server

# 性能测试

cargo bench

# 代码检查

cargo clippy

# 格式化

cargo fmt

📝 备注

- 复用优先: 70% 功能复用 qars,减少重复开发

- 类型安全: 使用 Rust 类型系统保证编译时安全

- 零拷贝: 通过 iceoryx2 实现高性能数据传输

- 并发优化: DashMap/parking_lot 无锁并发

- 真实场景: 参考 CTP/上交所设计

🎉 构建成功

当前进度: 基础框架 ✅ | 核心功能 30% | 完整度 40%

下一步: 实现完整的订单路由和成交回报流程 (P0)

构建日期: 2025-10-03 版本: 0.1.0 状态: 🟢 可编译运行

系统架构

深入了解 QAExchange-RS 的核心架构设计。

📄 文档列表

-

系统总览 - 整体架构与模块划分

- 系统架构图

- 模块职责

- 数据流

- 技术栈

-

高性能架构 - P99 < 100μs 延迟设计

- 零拷贝设计

- 无锁数据结构

- 异步非阻塞

- 性能优化策略

-

数据模型 - QIFI/TIFI/DIFF 协议详解

- QIFI 数据模型

- TIFI 传输协议

- DIFF 差分同步

- 协议扩展

-

交易机制 - 撮合引擎与交易流程

- 订单生命周期

- 撮合算法

- 风控机制

- 结算流程

-

解耦存储架构 - 零拷贝 + WAL 持久化

- 异步持久化

- 存储订阅器

- 性能特性

- 升级路径

🎯 核心设计理念

- 复用优先: 最大化复用 qars 核心组件

- 零拷贝: rkyv 序列化 + Arc 引用计数

- 异步非阻塞: Tokio 异步运行时

- 可扩展: 模块化设计,易于扩展

📚 后续阅读

了解架构后,推荐阅读:

系统架构设计

版本: v0.5.0 更新日期: 2025-12-18 (新增可观测性层、安全层、Phase 12-13 特性) 开发团队: @yutiansut @quantaxis

📋 目录

架构概览

系统架构图

┌─────────────────────────────────────────────────────────────────┐

│ 客户端层 (Client Layer) │

│ │

│ ┌──────────────┐ ┌──────────────┐ ┌──────────────┐ │

│ │ Web 前端 │ │ 移动端 App │ │ 交易终端 │ │

│ │ (React/Vue) │ │ (Flutter) │ │ (Desktop) │ │

│ └──────┬───────┘ └──────┬───────┘ └──────┬───────┘ │

│ │ │ │ │

└──────────┼─────────────────┼─────────────────┼───────────────────┘

│ │ │

HTTP REST WebSocket WebSocket

│ │ │

┌──────────▼─────────────────▼─────────────────▼───────────────────┐

│ 服务层 (Service Layer) │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ HTTP Server (Actix-web) Port: 8080 │ │

│ │ ├── CORS Middleware │ │

│ │ ├── Logger Middleware │ │

│ │ ├── Compression (Gzip) │ │

│ │ └── Routes: │ │

│ │ ├── /api/account/* (账户管理) │ │

│ │ ├── /api/order/* (订单管理) │ │

│ │ ├── /api/position/* (持仓查询) │ │

│ │ ├── /api/market/* (市场数据) │ │

│ │ ├── /admin/instruments/* (合约管理) 🔧 │ │

│ │ ├── /admin/settlement/* (结算管理) 🔧 │ │

│ │ ├── /admin/risk/* (风控管理) 🔧 │ │

│ │ └── /monitoring/* (系统监控) 🔧 │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ WebSocket Server (Actix-web-actors) Port: 8081 │ │

│ │ ├── Session Management (Actor Model) │ │

│ │ ├── Authentication & Authorization │ │

│ │ ├── Heartbeat (5s interval, 10s timeout) │ │

│ │ └── Message Routing: │ │

│ │ ├── Trading Messages (submit/cancel/query) │ │

│ │ └── Subscription (trade/orderbook/account) │ │

│ └─────────────────────────────────────────────────────────┘ │

└───────────────────────────┬───────────────────────────────────────┘

│

┌───────────────────────────▼───────────────────────────────────────┐

│ 业务层 (Business Layer) │

│ │

│ ┌──────────────────┐ ┌──────────────────┐ ┌──────────────┐ │

│ │ OrderRouter │ │ TradeGateway │ │ Settlement │ │

│ │ (订单路由) │ │ (成交网关) │ │ (结算引擎) │ │

│ │ │ │ │ │ │ │

│ │ • 订单接收 │ │ • 成交通知 │ │ • 日终结算 │ │

│ │ • 风控检查 │ │ • 账户更新 │ │ • 盯市盈亏 │ │

│ │ • 路由撮合 │ │ • 推送订阅者 │ │ • 强平处理 │ │

│ │ • 状态管理 │ │ • Pub/Sub │ │ • 结算历史 │ │

│ └────────┬─────────┘ └────────┬─────────┘ └──────────────┘ │

│ │ │ │

│ │ ┌────────────────▼─────────┐ │

│ │ │ PreTradeCheck (风控) │ │

│ │ │ • 资金检查 │ │

│ │ │ • 持仓限额 │ │

│ │ │ • 风险度检查 │ │

│ │ │ • 自成交防范 │ │

│ │ └──────────────────────────┘ │

└────────────┼──────────────────────────────────────────────────────┘

│

┌────────────▼──────────────────────────────────────────────────────┐

│ 核心层 (Core Layer) │

│ │

│ ┌──────────────────┐ ┌──────────────────┐ ┌──────────────┐ │

│ │ AccountManager │ │ MatchingEngine │ │ Instrument │ │

│ │ (账户管理) │ │ (撮合引擎) │ │ Registry │ │

│ │ │ │ │ │ (合约注册) 🔧│ │

│ │ • 开户/销户 │ │ • Orderbook │ │ • 合约信息 │ │

│ │ • 入金/出金 │ │ • 价格时间优先 │ │ • 生命周期 │ │

│ │ • 账户查询 │ │ • 撮合算法 │ │ • 参数配置 │ │

│ │ • 权限管理 │ │ • 成交生成 │ │ • 状态管理 │ │

│ └──────────────────┘ └──────────────────┘ └──────────────┘ │

│ │

│ ┌──────────────────┐ ┌──────────────────┐ ┌──────────────┐ │

│ │ SettlementEngine │ │ RiskMonitor │ │ SystemMonitor│ │

│ │ (结算引擎) 🔧 │ │ (风控监控) 🔧 │ │ (系统监控)🔧 │ │

│ │ │ │ │ │ │ │

│ │ • 设置结算价 │ │ • 风险账户 │ │ • CPU/内存 │ │

│ │ • 日终结算 │ │ • 保证金监控 │ │ • 存储监控 │ │

│ │ • 盈亏计算 │ │ • 强平检测 │ │ • 账户统计 │ │

│ │ • 强平处理 │ │ • 强平记录 │ │ • 性能指标 │ │

│ └──────────────────┘ └──────────────────┘ └──────────────┘ │

│ │

└───────────────────────────┬───────────────────────────────────────┘

│

┌───────────────────────────▼───────────────────────────────────────┐

│ 数据层 (Data Layer - 复用 qars) │

│ │

│ ┌──────────────────┐ ┌──────────────────┐ ┌──────────────┐ │

│ │ QA_Account │ │ QA_Position │ │ QA_Order │ │

│ │ (账户结构) │ │ (持仓结构) │ │ (订单结构) │ │

│ │ │ │ │ │ │ │

│ │ • QIFI 协议 │ │ • 多空持仓 │ │ • 订单状态 │ │

│ │ • 资金管理 │ │ • 今昨仓分离 │ │ • 成交记录 │ │

│ │ • 盈亏计算 │ │ • 成本计算 │ │ • 订单簿 │ │

│ └──────────────────┘ └──────────────────┘ └──────────────┘ │

│ │

│ ┌──────────────────────────────────────────────────────────┐ │

│ │ 数据持久化 (可选) │ │

│ │ ├── MongoDB (账户快照、订单记录) │ │

│ │ ├── ClickHouse (成交记录、行情数据) │ │

│ │ └── Redis (缓存、会话) │ │

│ └──────────────────────────────────────────────────────────┘ │

└───────────────────────────────────────────────────────────────────┘

核心设计原则

1. 高性能 (High Performance)

目标:

- 订单吞吐量: > 100K orders/sec

- 撮合延迟: P99 < 100μs

- WebSocket 并发: > 10K connections

实现:

- 异步非阻塞: Tokio 异步运行时

- 零拷贝通信: crossbeam unbounded channel

- 无锁并发: DashMap, parking_lot RwLock

- 内存池: 预分配对象池,减少 GC 压力

2. 类型安全 (Type Safety)

优势:

- 编译时保证: Rust 类型系统在编译时发现错误

- 无运行时异常: 无空指针、无数据竞争

- 强类型协议: QIFI/TIFI/MIFI 协议定义

示例:

#![allow(unused)] fn main() { // 编译时类型检查 pub enum OrderDirection { BUY, SELL, } pub enum OrderOffset { OPEN, CLOSE, CLOSETODAY, CLOSEYESTERDAY, } // 编译器确保只能使用合法值 fn submit_order(direction: OrderDirection, offset: OrderOffset) { // ... } }

3. 模块化 (Modularity)

分层解耦:

- 服务层: 不依赖具体业务实现

- 业务层: 可独立测试和替换

- 核心层: 纯粹的领域逻辑

- 数据层: 复用 qars 成熟组件

4. 可观测性 (Observability)

日志分级:

#![allow(unused)] fn main() { log::trace!("订单簿快照: {:?}", orderbook); log::debug!("订单 {} 提交成功", order_id); log::info!("账户 {} 开户成功", user_id); log::warn!("风险度 {:.2}% 接近阈值", risk_ratio * 100.0); log::error!("撮合引擎异常: {}", error); }

性能指标 (预留):

- 订单提交延迟分布

- 撮合引擎 TPS

- WebSocket 连接数

- 内存/CPU 使用率

分层架构

服务层 (Service Layer)

职责: 对外提供 HTTP 和 WebSocket 接口

HTTP Server:

#![allow(unused)] fn main() { pub struct HttpServer { app_state: Arc<AppState>, bind_address: String, } pub struct AppState { order_router: Arc<OrderRouter>, account_mgr: Arc<AccountManager>, } }

WebSocket Server:

#![allow(unused)] fn main() { pub struct WsSession { id: String, state: SessionState, // Unauthenticated | Authenticated heartbeat: Instant, subscribed_channels: Vec<String>, notification_receiver: Option<Receiver<Notification>>, } }

业务层 (Business Layer)

OrderRouter (订单路由器):

#![allow(unused)] fn main() { pub struct OrderRouter { account_mgr: Arc<AccountManager>, risk_checker: Arc<PreTradeCheck>, matching_engines: Arc<DashMap<String, Arc<RwLock<ExchangeMatchingEngine>>>>, orders: Arc<DashMap<String, OrderInfo>>, trade_gateway: Arc<TradeGateway>, order_seq: AtomicU64, } }

完整订单流程:

- 接收订单请求

- 风控检查 (PreTradeCheck)

- 路由到撮合引擎

- 处理撮合结果

- 更新账户状态 (TradeGateway)

- 推送通知给订阅者

TradeGateway (成交网关):

#![allow(unused)] fn main() { pub struct TradeGateway { account_mgr: Arc<AccountManager>, user_subscribers: Arc<DashMap<String, Vec<Sender<Notification>>>>, global_subscribers: Arc<DashMap<String, Sender<Notification>>>, trade_seq: AtomicU64, } }

Pub/Sub 模式:

- 用户订阅: 接收自己的成交/订单状态/账户更新

- 全局订阅: 接收指定合约的所有成交

核心层 (Core Layer)

AccountManager (账户管理器):

#![allow(unused)] fn main() { pub struct AccountManager { accounts: Arc<DashMap<String, Arc<RwLock<QA_Account>>>>, } impl AccountManager { pub fn open_account(&self, req: OpenAccountRequest) -> Result<String, ExchangeError>; pub fn get_account(&self, user_id: &str) -> Result<Arc<RwLock<QA_Account>>, ExchangeError>; pub fn deposit(&self, user_id: &str, amount: f64) -> Result<(), ExchangeError>; pub fn withdraw(&self, user_id: &str, amount: f64) -> Result<(), ExchangeError>; } }

MatchingEngine (撮合引擎):

- 复用 qars

ExchangeMatchingEngine - 价格-时间优先撮合算法

- 支持限价单、市价单

- 集合竞价支持 (预留)

数据层 (Data Layer)

复用 qars 核心数据结构:

QA_Account (账户):

#![allow(unused)] fn main() { pub struct QA_Account { pub user_id: String, pub accounts: Account, // 资金账户 pub hold: HashMap<String, QA_Position>, // 持仓 pub trades: Vec<QA_Trade>, // 成交记录 pub orders: BTreeMap<String, Order>, // 订单 } }

Account (资金结构):

#![allow(unused)] fn main() { pub struct Account { pub balance: f64, // 总权益 pub available: f64, // 可用资金 pub margin: f64, // 占用保证金 pub close_profit: f64, // 平仓盈亏 pub risk_ratio: f64, // 风险度 } }

QA_Position (持仓):

#![allow(unused)] fn main() { pub struct QA_Position { pub volume_long_today: f64, // 多头今仓 pub volume_long_his: f64, // 多头昨仓 pub volume_short_today: f64, // 空头今仓 pub volume_short_his: f64, // 空头昨仓 pub open_price_long: f64, // 多头开仓均价 pub open_price_short: f64, // 空头开仓均价 } }

存储层 (Storage Layer)

混合存储架构 (Hybrid OLTP/OLAP):

┌──────────────────────────────────────────────────────────────┐

│ Storage Layer │

│ │

│ OLTP Path (Low Latency) OLAP Path (Analytics) │

│ ↓ ↓ │

│ WAL WAL │

│ ↓ ↓ │

│ MemTable (SkipMap) MemTable (Arrow2 Columnar) │

│ ↓ ↓ │

│ SSTable (rkyv + mmap) SSTable (Parquet) │

│ ↓ ↓ │

│ Compaction + Bloom Filter Query Engine (Polars) │

└──────────────────────────────────────────────────────────────┘

WAL (Write-Ahead Log) - src/storage/wal/:

#![allow(unused)] fn main() { pub struct WalManager { dir: PathBuf, current_file: File, sequence: AtomicU64, } }

- CRC32 数据完整性校验

- 批量写入优化 (> 78K entries/sec)

- 崩溃恢复机制

- P99 < 50ms 写入延迟

MemTable - src/storage/memtable/:

- OLTP MemTable (

oltp.rs): SkipMap, P99 < 10μs - OLAP MemTable (

olap.rs): Arrow2 columnar format

SSTable - src/storage/sstable/:

- OLTP SSTable (

oltp_rkyv.rs): rkyv 零拷贝, P99 < 50μs - OLAP SSTable (

olap_parquet.rs): Parquet 列式存储 - Bloom Filter (

bloom.rs): 1% FP rate, ~100ns lookup - mmap Reader (

mmap_reader.rs): 零拷贝文件映射

Compaction - src/storage/compaction/:

- Leveled compaction 策略

- 后台压缩线程

- 自动触发和手动触发

Checkpoint - src/storage/checkpoint/:

- 快照创建

- 恢复管理

- 增量备份

Hybrid Storage - src/storage/hybrid/:

#![allow(unused)] fn main() { pub struct OltpHybridStorage { wal: Arc<WalManager>, memtable: Arc<RwLock<OltpMemTable>>, sstable_dir: PathBuf, } }

查询层 (Query Layer) ✨ Phase 8

查询引擎架构 - src/query/:

┌──────────────────────────────────────────────────────────────┐

│ Query Engine (Polars) │

│ │

│ QueryRequest ─→ SSTableScanner ─→ LazyFrame ─→ DataFrame │

│ │ │ │ │ │

│ │ │ │ │ │

│ SQL/Struct/ OLTP + OLAP Predicate Column │

│ TimeSeries SSTables Pushdown Pruning │

└──────────────────────────────────────────────────────────────┘

QueryEngine - src/query/engine.rs:

#![allow(unused)] fn main() { pub struct QueryEngine { scanner: SSTableScanner, } impl QueryEngine { pub fn execute(&self, request: QueryRequest) -> Result<QueryResponse, String>; } }

查询类型:

- SQL Query: 标准 SQL via Polars SQLContext

#![allow(unused)] fn main() { QueryType::Sql { query: "SELECT * FROM data WHERE price > 100 LIMIT 10" } }

- Structured Query: 程序化 API

#![allow(unused)] fn main() { QueryType::Structured { select: vec!["timestamp", "price", "volume"], from: "data", } // + filters, aggregations, order_by, limit }

- Time-Series Query: 时间序列聚合

#![allow(unused)] fn main() { QueryType::TimeSeries { metrics: vec!["price", "volume"], dimensions: vec!["instrument_id"], granularity: Some(60), // 60秒粒度 } }

性能优化:

- LazyFrame 延迟执行

- Predicate pushdown (谓词下推)

- Column pruning (列裁剪)

- Multi-file parallel scanning

- Parquet scan throughput: > 1GB/s

复制层 (Replication Layer) - Phase 6

Master-Slave Replication - src/replication/:

#![allow(unused)] fn main() { pub struct LogReplicator { role: Arc<RwLock<NodeRole>>, // Master/Slave/Candidate log_buffer: Arc<RwLock<Vec<ReplicationLogEntry>>>, } }

核心能力:

- 批量日志复制 (< 10ms 延迟)

- 心跳检测 (100ms 间隔)

- 自动故障转移 (< 500ms)

- Raft-inspired 选主算法

角色管理:

- Master: 接收写入, 复制日志到 Slave

- Slave: 只读, 接收日志并应用

- Candidate: 参与选主投票

因子计算层 (Factor Layer) ✨ NEW

流批一体因子引擎 - src/factor/:

┌──────────────────────────────────────────────────────────────┐

│ 因子计算系统架构 │

│ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ DSL 层 │ │ DAG 管理 │ │ 状态存储 │ │

│ │ (语法解析) │───▶│ (依赖拓扑) │───▶│ (物化视图) │ │

│ └─────────────┘ └─────────────┘ └─────────────┘ │

│ │ │ │ │

│ ▼ ▼ ▼ │

│ ┌─────────────────────────────────────────────────────┐ │

│ │ 流批一体执行引擎 │ │

│ │ ┌──────────────┐ ┌──────────────┐ │ │

│ │ │ Stream Engine│ │ Batch Engine │ │ │

│ │ │ (增量算子) │ │ (Polars SQL) │ │ │

│ │ └──────────────┘ └──────────────┘ │ │

│ └─────────────────────────────────────────────────────┘ │

└──────────────────────────────────────────────────────────────┘

核心组件:

- 增量算子 (

operators/): RollingMean, EMA, RSI, MACD 等 O(1) 算子 - 环形缓冲区 (

ring_buffer.rs): 滑动窗口高效实现 - Welford 算法 (

welford.rs): 数值稳定的在线统计 - 因子 DAG (

dag.rs): 依赖管理与并行计算 - 物化视图 (

view.rs): 因子状态持久化

性能指标:

- RollingMean.update(): ~15 ns (66M ops/s)

- RollingStd.update(): ~25 ns (Welford)

- 环形缓冲区 push: ~5 ns (200M ops/s)

集群管理层 (Cluster Layer) ✨ NEW

一致性哈希分片 - src/cluster/:

┌──────────────────────────────────────────────────────────────┐

│ 集群架构 │

│ │

│ ┌─────────────┐ │

│ │ ShardRouter │ ◀─── 路由缓存 │

│ └─────────────┘ │

│ │ │

│ ▼ │

│ ┌─────────────────────────────┐ │

│ │ ConsistentHashRing │ │

│ │ 0 ────────────── 2^64 │ │

│ │ │ N1 N2 N3 N1 N2 N3 │ ◀─── 虚拟节点 │

│ └─────────────────────────────┘ │

│ │ │

│ ▼ │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │ Node1 │ │ Node2 │ │ Node3 │ │

│ └─────────┘ └─────────┘ └─────────┘ │

└──────────────────────────────────────────────────────────────┘

核心能力:

- 一致性哈希: 节点变更时最小化数据迁移

- 虚拟节点: 150 个虚拟节点/物理节点

- 带权重节点: 高性能节点承担更多负载

- 副本分布: 多副本高可靠性

- 分片路由: 按账户ID/合约ID/订单ID分片

性能指标:

get_node(): ~100 nsroute()缓存命中: ~20 nsadd_node(): ~1 ms

DSL 层 (DSL Layer) ✨ NEW

因子定义语言 - src/dsl/:

#![allow(unused)] fn main() { // DSL 示例 ma5 = rolling_mean(close, 5) ma20 = rolling_mean(close, 20) ma_diff = ma5 - ma20 signal = if rsi > 70 then -1 else if rsi < 30 then 1 else 0 }

核心组件:

- 词法分析器 (

lexer.rs): Token 生成 - 语法解析器 (

parser.rs): AST 构建 (pest) - 语法定义 (

grammar.pest): PEG 语法规则

可观测性层 (Observability Layer) ✨ Phase 12

分布式追踪与监控 - src/observability/:

┌──────────────────────────────────────────────────────────────┐

│ Observability Stack │

│ │

│ ┌─────────────┐ ┌─────────────┐ ┌─────────────┐ │

│ │ Tracing │ │ Metrics │ │ Logging │ │

│ │ │ │ │ │ │ │

│ │ OpenTelemetry│ │ Prometheus │ │ tracing- │ │

│ │ + OTLP │ │ Exporter │ │ subscriber │ │

│ └──────┬──────┘ └──────┬──────┘ └──────┬──────┘ │

│ │ │ │ │

│ └──────────────────┴──────────────────┘ │

│ │ │

│ ┌───────▼───────┐ │

│ │ Grafana │ │

│ │ Dashboard │ │

│ └───────────────┘ │

└──────────────────────────────────────────────────────────────┘

OpenTelemetry 追踪

配置结构 - src/observability/tracing.rs:

#![allow(unused)] fn main() { pub struct TracingConfig { pub enabled: bool, pub service_name: String, pub service_version: String, pub environment: String, // dev/staging/prod pub exporter: ExporterType, // Otlp/Console/None pub endpoint: String, // OTLP endpoint pub sampling_rate: f64, // 0.0 - 1.0 pub batch_config: BatchExportConfig, pub log_filter: String, pub console_export: bool, } }

预置配置:

TracingConfig::development(): 100% 采样,控制台输出TracingConfig::production(endpoint): 10% 采样,OTLP 导出TracingConfig::test(): 100% 采样,控制台输出

Span 宏:

#![allow(unused)] fn main() { use qaexchange::{trace_span, trace_operation}; // 自动计时操作 let result = trace_operation!("match_order", { matching_engine.process_order(order)? }); // 输出: elapsed_us = xxx, "operation completed" }

Prometheus 指标

核心指标:

| 指标名 | 类型 | 说明 |

|--------|------|------|

| qaexchange_orders_total | Counter | 订单总数 |

| qaexchange_trades_total | Counter | 成交总数 |

| qaexchange_order_latency_seconds | Histogram | 订单延迟 |

| qaexchange_active_connections | Gauge | 活跃连接数 |

| qaexchange_memtable_size_bytes | Gauge | MemTable 大小 |

Grafana 大盘

预置面板 - config/grafana/dashboards/:

- 交易概览: 订单量、成交量、撮合延迟

- 存储状态: WAL 大小、MemTable 占用、SSTable 数量

- 系统健康: CPU、内存、磁盘 IO

- 复制状态: 主从延迟、心跳状态

性能指标:

- Span 创建开销: < 100ns

- 批量导出: 异步非阻塞

- 采样率: 可配置(生产环境建议 1-10%)

安全层 (Security Layer) ✨ Phase 13

TLS/mTLS 加密通信 - src/replication/tls.rs:

┌──────────────────────────────────────────────────────────────┐

│ TLS Security Architecture │

│ │

│ ┌──────────────────────────────────────────────────────┐ │

│ │ Certificate Chain │ │

│ │ │ │

│ │ ┌────────┐ │ │

│ │ │ Root CA │ (10 年有效期, 离线存储) │ │

│ │ └────┬───┘ │ │

│ │ │ signs │ │

│ │ ▼ │ │

│ │ ┌────────────┐ ┌────────────┐ │ │

│ │ │ Server Cert │ │ Client Cert │ (mTLS) │ │

│ │ │ (1 年) │ │ (1 年) │ │ │

│ │ └────────────┘ └────────────┘ │ │

│ └──────────────────────────────────────────────────────┘ │

│ │

│ 加密算法: │

│ - TLS 1.3 │

│ - AES-256-GCM / ChaCha20-Poly1305 │

│ - RSA 2048 / ECDSA P-256 │

└──────────────────────────────────────────────────────────────┘

CertificateGenerator API

#![allow(unused)] fn main() { use qaexchange::replication::tls::CertificateGenerator; // 生成自签名 CA let ca = CertificateGenerator::generate_ca_certificate( "QAExchange CA", 365 * 10 )?; // 生成服务器证书 let server = CertificateGenerator::generate_server_certificate( &ca, "server", &["localhost", "192.168.1.100"], 365 )?; // 生成客户端证书 (mTLS) let client = CertificateGenerator::generate_client_certificate( &ca, "trader-001", 365 )?; }

TLS 配置构建器

#![allow(unused)] fn main() { use qaexchange::replication::tls::TlsConfigBuilder; // 服务端 mTLS 配置 let server_config = TlsConfigBuilder::new() .with_certificate_paths(&server_paths)? .require_client_auth(&ca_paths)? // mTLS .build_server_config()?; // 客户端配置 let client_config = TlsConfigBuilder::new() .with_certificate_paths(&client_paths)? .with_ca_certificate(&ca_paths)? .build_client_config()?; }

SIMD 优化

运行时检测 - src/ipc/simd.rs:

#![allow(unused)] fn main() { pub struct SimdCapabilities { pub avx2: bool, // x86_64 AVX2 (256-bit) pub avx512: bool, // x86_64 AVX-512 (512-bit) pub sse42: bool, // x86_64 SSE4.2 pub neon: bool, // ARM NEON } // 自动选择最优实现 let caps = SimdCapabilities::detect(); }

优化函数:

| 函数 | Scalar | SIMD | 加速比 |

|------|--------|------|--------|

| find_best_price(1K) | 800ns | 150ns | 5.3x |

| sum_volumes(1K) | 500ns | 100ns | 5x |

| crc32(4KB) | 2μs | 400ns | 5x |

Block Index

块级索引 - src/storage/sstable/block_index.rs:

┌──────────────────────────────────────────────────────────────┐

│ SSTable with Block Index │

│ │

│ Block Index (Binary Search O(log n)) │

│ ┌──────────────────────────────────────────────────────┐ │

│ │ Block 0: offset=0, ts=1000-1099, count=100 │ │

│ │ Block 1: offset=4096, ts=1100-1199, count=100 │ │

│ │ Block 2: offset=8192, ts=1200-1299, count=100 │ │

│ └──────────────────────────────────────────────────────┘ │

│ │ │

│ ▼ │

│ Data Blocks │

│ ┌─────────┐ ┌─────────┐ ┌─────────┐ │

│ │ Block 0 │ │ Block 1 │ │ Block 2 │ ... │

│ │ 4KB │ │ 4KB │ │ 4KB │ │

│ └─────────┘ └─────────┘ └─────────┘ │

└──────────────────────────────────────────────────────────────┘

性能指标:

- 索引查找: O(log n)

- 范围查询 (1M blocks): ~500ns

- 内存开销/entry: 48 bytes

管理端架构

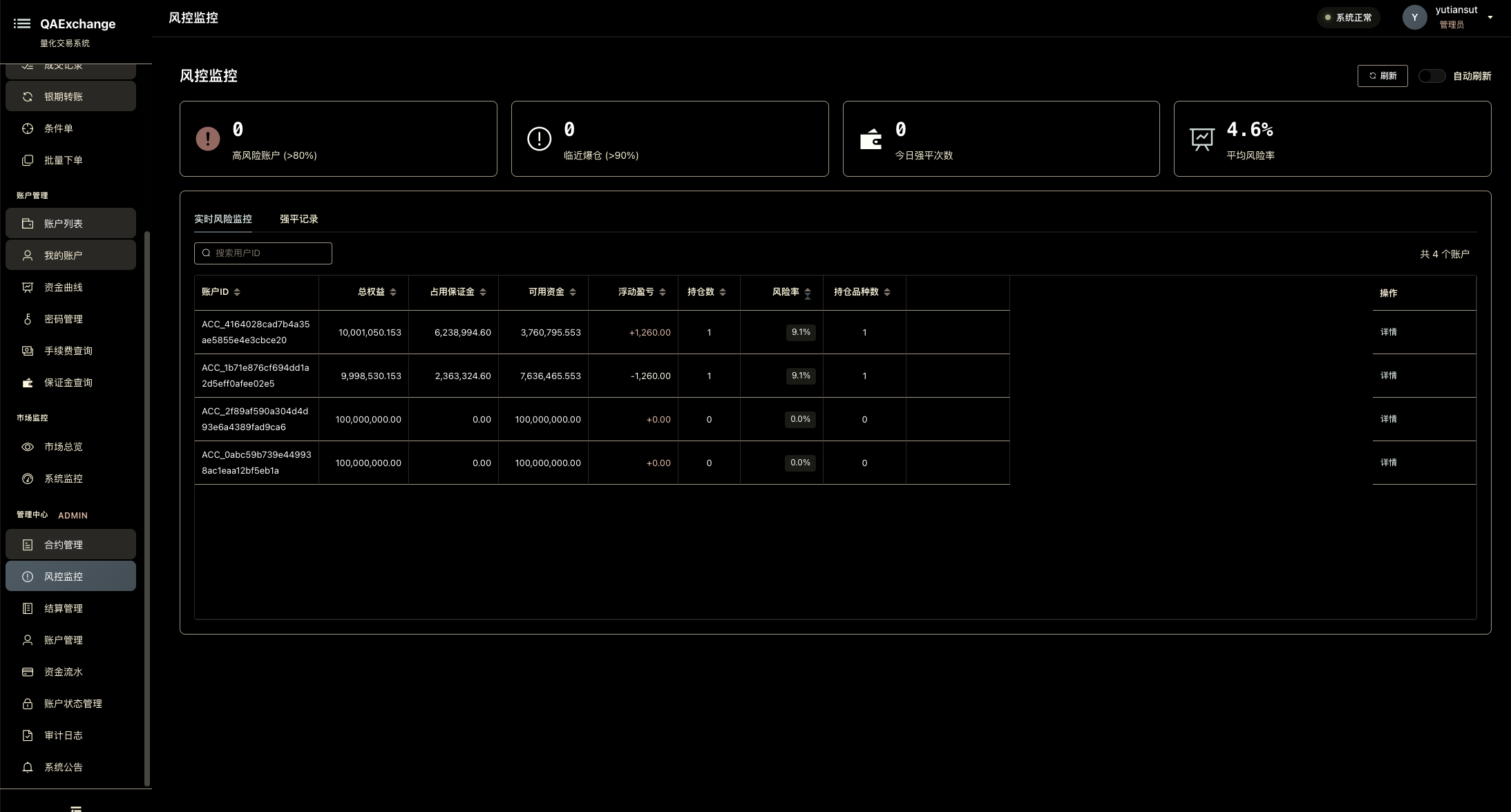

概述

管理端提供合约管理、结算管理、风控监控和系统监控等管理员功能,确保交易所的稳定运行和合规操作。

管理端数据流

┌──────────────────────────────────────────────────────────────┐

│ 管理端数据流 │

│ │

│ 管理员 → 前端界面 → HTTP API → 管理端模块 → 核心引擎 → 存储 │

│ │

│ ┌─────────┐ ┌──────────┐ ┌─────────────┐ ┌─────────┐ │

│ │ 管理员 │ → │ Admin UI │ → │ Admin API │ → │ Core │ │

│ │ │ │ │ │ │ │ Engines │ │

│ │ • 合约 │ │ • Vue.js │ │ • Actix-web │ │ │ │

│ │ • 结算 │ │ • Element│ │ • REST │ │ • 账户 │ │

│ │ • 风控 │ │ UI │ │ • JSON │ │ • 撮合 │ │

│ │ • 监控 │ │ • ECharts│ │ │ │ • 存储 │ │

│ └─────────┘ └──────────┘ └─────────────┘ └─────────┘ │

└──────────────────────────────────────────────────────────────┘

核心模块

1. InstrumentRegistry (合约注册表)

职责: 管理合约的全生命周期

核心功能:

#![allow(unused)] fn main() { pub struct InstrumentRegistry { instruments: Arc<DashMap<String, InstrumentInfo>>, } impl InstrumentRegistry { // 合约注册与管理 pub fn register(&self, instrument: InstrumentInfo) -> Result<()> pub fn update(&self, id: &str, updater: impl FnOnce(&mut InstrumentInfo)) -> Result<()> // 状态管理 pub fn suspend(&self, id: &str) -> Result<()> // 暂停交易 pub fn resume(&self, id: &str) -> Result<()> // 恢复交易 pub fn delist(&self, id: &str) -> Result<()> // 下市合约 // 查询 pub fn get(&self, id: &str) -> Option<InstrumentInfo> pub fn list_all(&self) -> Vec<InstrumentInfo> } }

合约生命周期:

创建 → 上市 → 交易中 ⇄ 暂停 → 下市

(register) (Trading) (Suspended) (Delisted)

下市安全检查:

- 遍历所有账户

- 检查是否有未平仓持仓

- 返回详细错误信息(包含持仓账户列表)

- 防止数据不一致

2. SettlementEngine (结算引擎)

职责: 执行日终结算和强平处理

核心功能:

#![allow(unused)] fn main() { pub struct SettlementEngine { account_mgr: Arc<AccountManager>, settlement_prices: Arc<DashMap<String, f64>>, settlement_history: Arc<DashMap<String, SettlementResult>>, force_close_threshold: f64, // 强平阈值(默认1.0 = 100%) } impl SettlementEngine { // 结算价管理 pub fn set_settlement_price(&self, instrument_id: String, price: f64) pub fn set_settlement_prices(&self, prices: HashMap<String, f64>) // 日终结算 pub fn daily_settlement(&self) -> Result<SettlementResult> // 单个账户结算 fn settle_account(&self, user_id: &str, date: &str) -> Result<AccountSettlement> // 强平处理 pub fn force_close_account(&self, user_id: &str) -> Result<()> // 查询 pub fn get_settlement_history(&self) -> Vec<SettlementResult> pub fn get_settlement_detail(&self, date: &str) -> Option<SettlementResult> } }

结算流程:

1. 设置结算价

↓

2. 遍历所有账户

↓

3. 计算持仓盈亏(盯市)

• 多头盈亏 = (结算价 - 开仓价) × 多头数量 × 合约乘数

• 空头盈亏 = (开仓价 - 结算价) × 空头数量 × 合约乘数

↓

4. 计算累计手续费

• 从账户累计值获取

↓

5. 更新账户权益

• 新权益 = 原权益 + 持仓盈亏 + 平仓盈亏 - 手续费

↓

6. 计算风险度

• 风险度 = 占用保证金 / 账户权益

↓

7. 检查强平

• 如果风险度 >= 100%,记录强平账户

↓

8. 保存结算结果

• 总账户数、成功数、失败数

• 强平账户列表

• 总手续费、总盈亏

强平处理:

- 自动识别风险度 >= 100% 的账户

- 记录到

force_closed_accounts列表 - 可配置强平阈值

3. RiskMonitor (风控监控) ⚠️ 部分实现

职责: 实时监控账户风险

规划功能:

#![allow(unused)] fn main() { pub struct RiskMonitor { account_mgr: Arc<AccountManager>, risk_threshold: f64, } impl RiskMonitor { // 风险账户筛选 pub fn get_risk_accounts(&self, threshold: f64) -> Vec<RiskAccount> // 保证金监控汇总 pub fn get_margin_summary(&self) -> MarginSummary // 强平记录 pub fn get_liquidation_records(&self, start_date: &str, end_date: &str) -> Vec<LiquidationRecord> } }

风险等级:

- 正常: 风险度 < 50%

- 警告: 50% ≤ 风险度 < 80%

- 高风险: 80% ≤ 风险度 < 100%

- 强平: 风险度 >= 100%

状态: 前端已实现,后端API待开发

4. SystemMonitor (系统监控)

职责: 监控系统运行状态

核心功能:

#![allow(unused)] fn main() { pub struct SystemMonitor { account_mgr: Arc<AccountManager>, storage_subscriber: Arc<StorageSubscriber>, } impl SystemMonitor { // 系统状态 pub fn get_system_status(&self) -> SystemStatus { SystemStatus { cpu_usage: get_cpu_usage(), memory_usage: get_memory_usage(), disk_usage: get_disk_usage(), uptime: get_uptime(), process_count: get_process_count(), } } // 存储监控 pub fn get_storage_status(&self) -> StorageStatus { let stats = self.storage_subscriber.get_stats(); StorageStatus { wal_size: stats.wal_size, wal_files: stats.wal_files, memtable_size: stats.memtable_size, memtable_entries: stats.memtable_entries, sstable_count: stats.sstable_count, sstable_size: stats.sstable_size, } } // 账户监控 pub fn get_account_stats(&self) -> AccountStats // 订单监控 pub fn get_order_stats(&self) -> OrderStats // 成交监控 pub fn get_trade_stats(&self) -> TradeStats // 生成报告 pub fn generate_report(&self) -> MonitoringReport } }

监控指标:

系统层:

• CPU使用率

• 内存使用率

• 磁盘使用率

• 运行时间

• 进程数

存储层:

• WAL大小和文件数

• MemTable大小和条目数

• SSTable数量和总大小

业务层:

• 账户总数/活跃数

• 总资金/总保证金

• 订单总数/待处理数

• 成交总数/总成交额

管理端API路由

| 功能模块 | API路由 | 数量 | 状态 |

|---|---|---|---|

| 合约管理 | /admin/instruments/* | 6个 | ✅ |

| 结算管理 | /admin/settlement/* | 5个 | ✅ |

| 风控管理 | /admin/risk/* | 3个 | ⚠️ |

| 系统监控 | /monitoring/* | 6个 | ✅ |

权限控制:

- 管理端API需要管理员权限

- Token验证 (JWT)

- 操作审计日志

管理端前端页面

| 页面 | 路由 | 功能 | 状态 |

|---|---|---|---|

| 合约管理 | /admin-instruments | 合约CRUD、状态管理 | ✅ |

| 结算管理 | /admin-settlement | 设置结算价、执行结算、查询历史 | ✅ |

| 风控监控 | /admin-risk | 风险账户、保证金监控、强平记录 | ✅ |

| 账户管理 | /admin-accounts | 账户列表、详情、审核 | ✅ |

| 交易管理 | /admin-transactions | 全市场成交、订单统计 | ✅ |

| 系统监控 | /monitoring | 系统/存储/业务监控 | ✅ |

技术栈:

- Vue 2.6.11

- Element UI

- vxe-table

- ECharts

数据流示例:日终结算

1. 管理员设置结算价

POST /admin/settlement/batch-set-prices

{

"prices": [

{ "instrument_id": "IF2501", "settlement_price": 3850.0 },

{ "instrument_id": "IH2501", "settlement_price": 2650.0 }

]

}

↓

2. SettlementEngine 存储结算价

settlement_prices.insert("IF2501", 3850.0)

settlement_prices.insert("IH2501", 2650.0)

↓

3. 管理员执行结算

POST /admin/settlement/execute

↓

4. SettlementEngine 遍历账户

accounts = account_mgr.get_all_accounts()

for account in accounts {

settle_account(account)

}

↓

5. 计算盈亏并更新账户

• 持仓盈亏 = f(结算价, 开仓价, 数量)

• 新权益 = 原权益 + 盈亏 - 手续费

• 风险度 = 保证金 / 权益

↓

6. 识别强平账户

if risk_ratio >= 100% {

force_closed_accounts.push(user_id)

}

↓

7. 返回结算结果

{

"settlement_date": "2025-10-05",

"total_accounts": 1250,

"settled_accounts": 1247,

"failed_accounts": 3,

"force_closed_accounts": ["user123", "user456"],

"total_commission": 152340.50,

"total_profit": -234560.75

}

数据流设计

订单提交流程

┌─────────┐

│ 客户端 │

└────┬────┘

│ 1. POST /api/order/submit

▼

┌─────────────────────────┐

│ HTTP Handler │

│ (handlers::submit_order)│

└────┬────────────────────┘

│ 2. SubmitOrderRequest

▼

┌─────────────────────────┐

│ OrderRouter │

│ .submit_order() │

└────┬────────────────────┘

│ 3. 生成订单ID (原子递增)

│

├─────────────────────┐

│ ▼

│ ┌──────────────┐

│ │ PreTradeCheck│

│ │ .check() │

│ └──────┬───────┘

│ │

│ 4. RiskCheckResult │

│◄────────────────────┘

│

│ 5. 通过 → 创建订单

│ 拒绝 → 返回错误

│

├─────────────────────┐

│ ▼

│ ┌───────────────────┐

│ │ MatchingEngine │

│ │ .process_order() │

│ └───────┬───────────┘

│ │

│ 6. Vec<Result> │

│◄────────────────┘

│

├─────────────────────┐

│ ▼

│ ┌───────────────────┐

│ │ TradeGateway │

│ │ .handle_filled() │

│ └───────┬───────────┘

│ │

│ ├─ 7a. 更新账户

│ ├─ 7b. 推送成交通知

│ └─ 7c. 推送账户更新

│

▼

┌─────────────────────────┐

│ WebSocket Subscribers │

│ (实时接收通知) │

└─────────────────────────┘

WebSocket 实时推送流程

┌──────────┐

│ 客户端 │

└────┬─────┘

│ 1. WebSocket 连接

│ ws://localhost:8081/ws?user_id=user001

▼

┌─────────────────────────┐

│ WsSession (Actor) │

│ .started() │

└────┬────────────────────┘

│ 2. 注册到 WebSocketServer

│

├─────────────────────┐

│ ▼

│ ┌───────────────────┐

│ │ TradeGateway │

│ │ .subscribe() │

│ └───────────────────┘

│

│ 3. 客户端发送认证

│ { "type": "auth", "user_id": "...", "token": "..." }

▼

┌─────────────────────────┐

│ WsMessageHandler │

│ .handle_message() │

└────┬────────────────────┘

│ 4. 验证 Token

│ SessionState → Authenticated

│

│ 5. 客户端订阅

│ { "type": "subscribe", "channels": ["trade", "account_update"] }

│

│ 6. 当有成交时

│ TradeGateway.send_notification()

│

├──────────────────────────┐

│ ▼

│ ┌──────────────────────┐

│ │ crossbeam::channel │

│ │ (Sender → Receiver) │

│ └──────────┬───────────┘

│ │

│ 7. WsSession.started() │

│ 10ms 轮询接收 │

│◄────────────────────────┘

│

▼

┌─────────────────────────┐

│ 客户端接收消息 │

│ ws.onmessage() │

└─────────────────────────┘

并发模型

1. Actor 模型 (WebSocket 会话)

Actix Actor:

- 每个 WebSocket 连接 = 1 个 Actor

- Actor 之间通过消息传递通信

- 自动处理并发,无需手动加锁

#![allow(unused)] fn main() { impl Actor for WsSession { type Context = ws::WebsocketContext<Self>; fn started(&mut self, ctx: &mut Self::Context) { // 启动心跳 self.start_heartbeat(ctx); // 轮询通知 ctx.run_interval(Duration::from_millis(10), |act, ctx| { // 非阻塞接收 while let Ok(notification) = act.notification_receiver.try_recv() { // 发送给客户端 } }); } } }

2. 无锁并发 (DashMap)

DashMap 优势:

- 分段锁设计,并发读写性能优异

- 无需手动加锁,API 自动处理

- 适合高并发场景

#![allow(unused)] fn main() { // 订单存储 orders: Arc<DashMap<String, OrderInfo>> // 并发读写无需锁 self.orders.insert(order_id.clone(), order_info); let order = self.orders.get(&order_id); }

3. 读写锁 (RwLock)

parking_lot RwLock:

- 比标准库 RwLock 性能更好

- 读锁可并发,写锁独占

#![allow(unused)] fn main() { // 账户存储 accounts: Arc<DashMap<String, Arc<RwLock<QA_Account>>>> // 读操作(并发) let account = self.account_mgr.get_account(user_id)?; let acc = account.read(); // 多个线程可同时读 let balance = acc.accounts.balance; // 写操作(独占) let mut acc = account.write(); // 独占锁 acc.accounts.balance += 10000.0; drop(acc); // 尽早释放锁 }

4. 原子操作 (AtomicU64)

无锁递增:

#![allow(unused)] fn main() { order_seq: AtomicU64 // 原子递增生成订单ID let seq = self.order_seq.fetch_add(1, Ordering::SeqCst); let order_id = format!("O{}{:016}", timestamp, seq); }

性能优化

1. 内存管理

避免频繁分配:

#![allow(unused)] fn main() { // 预分配容量 let mut orders = Vec::with_capacity(1000); // 对象池复用 let order = order_pool.acquire(); }

尽早释放锁:

#![allow(unused)] fn main() { { let acc = account.read(); let balance = acc.accounts.balance; // 获取数据 } // acc 被 drop,锁被释放 process_balance(balance); // 无锁操作 }

2. 异步非阻塞

Tokio 异步运行时:

#[tokio::main] async fn main() { // HTTP 服务器异步运行 let http_server = HttpServer::new(...); tokio::spawn(async move { http_server.run().await.unwrap(); }); // WebSocket 服务器异步运行 let ws_server = WebSocketServer::new(...); tokio::spawn(async move { ws_server.run().await.unwrap(); }); // 等待所有服务 tokio::signal::ctrl_c().await.unwrap(); }

3. 零拷贝通信

crossbeam unbounded channel:

#![allow(unused)] fn main() { // 发送端 let (tx, rx) = crossbeam::channel::unbounded(); tx.send(notification).unwrap(); // 非阻塞 // 接收端 while let Ok(msg) = rx.try_recv() { // 非阻塞 process(msg); } }

4. 批量处理

批量撮合:

#![allow(unused)] fn main() { // 收集一批订单 let mut batch = Vec::with_capacity(100); while batch.len() < 100 { if let Ok(order) = order_rx.try_recv() { batch.push(order); } else { break; } } // 批量处理 for order in batch { matching_engine.process_order(order); } }

扩展性设计

1. 水平扩展

多实例部署:

┌─────────────┐ ┌─────────────┐ ┌─────────────┐

│ Instance 1 │ │ Instance 2 │ │ Instance 3 │

│ HTTP:8080 │ │ HTTP:8080 │ │ HTTP:8080 │

│ WS:8081 │ │ WS:8081 │ │ WS:8081 │

└──────┬──────┘ └──────┬──────┘ └──────┬──────┘

│ │ │

└────────────────────┴────────────────────┘

│

┌─────────▼─────────┐

│ Load Balancer │

│ (Nginx/HAProxy) │

└───────────────────┘

注意事项:

- WebSocket 需要 sticky session

- 订单路由需要确保同一用户请求到同一实例

- 共享状态通过 Redis 同步

2. 垂直扩展

模块拆分:

┌────────────────┐

│ Gateway │ (API 网关)

└───────┬────────┘

│

┌───────┴────────┐

│ │

▼ ▼

┌──────────┐ ┌──────────┐

│ Trading │ │ Market │ (交易服务 | 行情服务)

│ Service │ │ Service │

└──────────┘ └──────────┘

3. 插件化

撮合引擎可替换:

#![allow(unused)] fn main() { pub trait MatchingEngine { fn process_order(&mut self, order: Order) -> Vec<Result<Success, Failed>>; } // 默认实现 struct DefaultMatchingEngine { ... } // 自定义实现 struct CustomMatchingEngine { ... } }

风控策略可配置:

#![allow(unused)] fn main() { pub struct RiskConfig { pub max_position_ratio: f64, pub risk_ratio_reject: f64, // ... 可通过配置文件动态加载 } }

安全设计

1. 认证授权

Token 认证:

#![allow(unused)] fn main() { // WebSocket 认证 ClientMessage::Auth { user_id, token } => { if verify_token(&user_id, &token) { session.state = SessionState::Authenticated { user_id }; } } }

2. 风控保护

多层风控:

- 盘前风控: PreTradeCheck 检查资金、持仓、风险度

- 盘中监控: 实时计算风险度,接近阈值预警

- 强平机制: 风险度超限自动强平

3. 参数校验

严格校验:

#![allow(unused)] fn main() { fn check_order_params(req: &OrderCheckRequest) -> Result<(), ExchangeError> { if req.volume < config.min_order_volume { return Err(ExchangeError::InvalidOrderParams("数量过小".into())); } if req.price <= 0.0 { return Err(ExchangeError::InvalidOrderParams("价格非法".into())); } Ok(()) } }

数据协议

QIFI (Quantitative Investment Format Interface)

账户标准格式:

{

"account_cookie": "user001",

"portfolio": "default",

"account_type": "individual",

"money": 1000000.0,

"available": 950000.0,

"margin": 50000.0,

"positions": [

{

"instrument_id": "IX2301",

"volume_long": 10,

"volume_short": 0,

"open_price_long": 120.0,

"profit": 500.0

}

],

"trades": [ ... ],

"orders": [ ... ]

}

文档更新: 2025-10-03 维护者: @yutiansut

高性能交易所架构设计

设计目标

- 订单吞吐: > 1,000,000 orders/sec

- 撮合延迟: P99 < 100μs

- 行情延迟: P99 < 10μs

- 并发账户: > 100,000

- 零拷贝通信: iceoryx2 共享内存

架构原则(参考上交所/CTP)

1. 职责分离

| 系统 | 职责 | 独立性 |

|---|---|---|

| 撮合引擎 | 订单匹配(价格优先、时间优先) | 独立进程 |

| 账户系统 | 资金/持仓管理 | 独立进程 |

| 风控系统 | 盘前/盘中风控 | 独立服务 |

| 行情系统 | Level1/Level2/逐笔推送 | 独立进程 |

| 交易网关 | WebSocket/HTTP 接入 | 多实例 |

2. 通信机制

iceoryx2 共享内存(零拷贝)

↓

订单请求 → 撮合引擎 → 成交回报 → 账户系统

↓

行情系统

3. 数据流向

用户订单流:

Client → Gateway → RiskCheck → OrderRouter

↓ (iceoryx2)

MatchingEngine

↓ (iceoryx2)

┌──────────┴──────────┐

↓ ↓

AccountSystem MarketData

↓ ↓

TradeNotify Subscribers

核心组件设计

组件 1: 撮合引擎核心 (MatchingEngineCore)

独立进程,每个品种一个 Orderbook

#![allow(unused)] fn main() { // src/matching/core/mod.rs use qars::qadatastruct::orderbook::{Orderbook, Success, Failure}; pub struct MatchingEngineCore { // 订单簿池(每个品种独立) orderbooks: DashMap<String, Arc<RwLock<Orderbook<InstrumentAsset>>>>, // iceoryx2 订单接收器 order_receiver: Receiver<OrderRequest>, // iceoryx2 成交发送器 trade_sender: Sender<TradeReport>, // iceoryx2 行情发送器 market_sender: Sender<OrderbookSnapshot>, // iceoryx2 订单确认发送器(Sim模式) accepted_sender: Sender<OrderAccepted>, } impl MatchingEngineCore { pub fn run(&self) { while let Ok(order_req) = self.order_receiver.recv() { let instrument_id = std::str::from_utf8(&order_req.instrument_id) .unwrap_or("") .trim_end_matches('\0'); // 1. 获取对应的订单簿 if let Some(orderbook) = self.orderbooks.get(instrument_id) { let mut ob = orderbook.write(); // 2. 撮合(纯内存操作) let result = ob.insert_order( order_req.price, order_req.volume, order_req.direction == 0, // true=BUY, false=SELL ); // 3. 处理撮合结果 match result { Ok(success) => self.handle_success(success, &order_req), Err(failure) => self.handle_failure(failure, &order_req), } // 4. 发送行情更新(零拷贝) let snapshot = self.create_snapshot(&ob, instrument_id); let _ = self.market_sender.send(snapshot); } } } fn handle_success(&self, success: Success, req: &OrderRequest) { match success { Success::Accepted { id, ts, .. } => { // 订单进入订单簿 → 发送确认消息 let accepted = self.create_order_accepted(req, ts); let _ = self.accepted_sender.send(accepted); log::info!("Order accepted: {:?}", id); } Success::Filled { id, ts, price, volume, trades } => { // 完全成交 → 发送成交回报 for trade in trades { let trade_report = self.create_trade_report(req, &trade, ts); let _ = self.trade_sender.send(trade_report); } log::info!("Order filled: {:?} @ {} x {}", id, price, volume); } Success::PartiallyFilled { id, ts, filled_volume, trades, .. } => { // 部分成交 → 发送成交回报 for trade in trades { let trade_report = self.create_trade_report(req, &trade, ts); let _ = self.trade_sender.send(trade_report); } log::info!("Order partially filled: {:?}, filled {}", id, filled_volume); } } } fn create_order_accepted(&self, req: &OrderRequest, timestamp: i64) -> OrderAccepted { let mut accepted = OrderAccepted { order_id: req.order_id, exchange_order_id: [0; 32], user_id: req.user_id, instrument_id: req.instrument_id, timestamp, gateway_id: req.gateway_id, session_id: req.session_id, }; // 生成全局唯一的 exchange_order_id let instrument_id = std::str::from_utf8(&req.instrument_id) .unwrap_or("") .trim_end_matches('\0'); let direction_str = if req.direction == 0 { "B" } else { "S" }; let exchange_order_id = format!("EX_{}_{}{}", timestamp, instrument_id, direction_str); let ex_bytes = exchange_order_id.as_bytes(); let ex_len = ex_bytes.len().min(32); accepted.exchange_order_id[..ex_len].copy_from_slice(&ex_bytes[..ex_len]); accepted } fn create_trade_report(&self, req: &OrderRequest, trade: &Trade, timestamp: i64) -> TradeReport { let mut report = TradeReport { trade_id: [0; 32], order_id: req.order_id, exchange_order_id: [0; 32], user_id: req.user_id, instrument_id: req.instrument_id, direction: req.direction, offset: req.offset, price: trade.price, volume: trade.volume, timestamp, commission: trade.volume * 0.05, // 示例手续费 }; // 生成 trade_id let trade_id = format!("TRADE_{}", timestamp); let trade_bytes = trade_id.as_bytes(); let trade_len = trade_bytes.len().min(32); report.trade_id[..trade_len].copy_from_slice(&trade_bytes[..trade_len]); // 生成 exchange_order_id(与 OrderAccepted 相同格式) let instrument_id = std::str::from_utf8(&req.instrument_id) .unwrap_or("") .trim_end_matches('\0'); let direction_str = if req.direction == 0 { "B" } else { "S" }; let exchange_order_id = format!("EX_{}_{}{}", timestamp, instrument_id, direction_str); let ex_bytes = exchange_order_id.as_bytes(); let ex_len = ex_bytes.len().min(32); report.exchange_order_id[..ex_len].copy_from_slice(&ex_bytes[..ex_len]); report } } }

关键点:

- 双消息机制:Success::Accepted → OrderAccepted;Success::Filled → TradeReport

- exchange_order_id 生成:格式

EX_{timestamp}_{instrument}_{direction},全局唯一 - order_id 传递:从 Gateway 接收并在所有消息中传递,用于账户匹配

- 纯内存操作:无需锁定账户,专注于撮合逻辑

- 零拷贝通信:减少序列化开销

组件 2: 账户系统 (AccountSystemCore)

独立进程,异步更新账户

#![allow(unused)] fn main() { // src/account/core/mod.rs use crossbeam::channel::{Receiver, Sender, select}; pub struct AccountSystemCore { // 账户池 accounts: DashMap<String, Arc<RwLock<QA_Account>>>, // iceoryx2 成交订阅器 trade_receiver: Receiver<TradeReport>, // iceoryx2 订单确认订阅器(Sim模式必需) accepted_receiver: Receiver<OrderAccepted>, // 账户更新通知发送器(可选) update_sender: Option<Sender<AccountUpdateNotify>>, // 更新队列(批量处理) batch_size: usize, } impl AccountSystemCore { pub fn run(&self) { use crossbeam::channel::select; let mut update_queue = Vec::with_capacity(self.batch_size); loop { // 使用 select! 监听多个通道 select! { // 1. 接收订单确认(Sim模式) recv(self.accepted_receiver) -> msg => { if let Ok(accepted) = msg { self.handle_order_accepted(accepted); } } // 2. 接收成交回报 recv(self.trade_receiver) -> msg => { if let Ok(trade) = msg { update_queue.push(trade); // 达到批量大小,立即处理 if update_queue.len() >= self.batch_size { self.batch_update_accounts(&update_queue); update_queue.clear(); } } } // 3. 超时处理(确保队列不会无限等待) default(Duration::from_millis(10)) => { if !update_queue.is_empty() { self.batch_update_accounts(&update_queue); update_queue.clear(); } } } } } fn handle_order_accepted(&self, accepted: OrderAccepted) { let order_id = std::str::from_utf8(&accepted.order_id) .unwrap_or("") .trim_end_matches('\0'); let exchange_order_id = std::str::from_utf8(&accepted.exchange_order_id) .unwrap_or("") .trim_end_matches('\0'); let user_id = std::str::from_utf8(&accepted.user_id) .unwrap_or("") .trim_end_matches('\0'); if let Some(account) = self.accounts.get(user_id) { let mut acc = account.write(); if let Err(e) = acc.on_order_confirm(order_id, exchange_order_id) { log::error!("Failed to confirm order {}: {}", order_id, e); } } } fn batch_update_accounts(&self, update_queue: &[TradeReport]) { // 按账户分组 let mut grouped: HashMap<String, Vec<TradeReport>> = HashMap::new(); for trade in update_queue { let user_id = std::str::from_utf8(&trade.user_id) .unwrap_or("") .trim_end_matches('\0') .to_string(); grouped.entry(user_id) .or_insert(Vec::new()) .push(*trade); } // 并行更新(每个账户独立锁) grouped.par_iter().for_each(|(user_id, trades)| { if let Some(account) = self.accounts.get(user_id) { let mut acc = account.write(); for trade in trades { self.apply_trade(&mut acc, trade); } } }); } fn apply_trade(&self, acc: &mut QA_Account, trade: &TradeReport) { let order_id = std::str::from_utf8(&trade.order_id) .unwrap_or("") .trim_end_matches('\0'); let exchange_order_id = std::str::from_utf8(&trade.exchange_order_id) .unwrap_or("") .trim_end_matches('\0'); let instrument_id = std::str::from_utf8(&trade.instrument_id) .unwrap_or("") .trim_end_matches('\0'); let datetime = chrono::Utc::now().format("%Y-%m-%d %H:%M:%S").to_string(); // 计算 towards(qars标准) let towards = match (trade.direction, trade.offset) { (0, 0) => 1, // BUY OPEN (1, 0) => -2, // SELL OPEN (0, 1) => 3, // BUY CLOSE (1, 1) => -3, // SELL CLOSE _ => 1, }; // 更新订单的 exchange_order_id(重要!) if let Some(order) = acc.dailyorders.get_mut(order_id) { order.exchange_order_id = exchange_order_id.to_string(); } // 调用 sim 模式的成交处理 if let Err(e) = acc.receive_deal_sim( order_id, exchange_order_id, instrument_id, towards, trade.price, trade.volume, &datetime, ) { log::error!("Failed to apply trade for {}: {}", order_id, e); } } } }

关键点:

- 双通道监听:使用

crossbeam::select!同时监听 OrderAccepted 和 TradeReport - Sim模式流程:先

on_order_confirm()更新 exchange_order_id,再receive_deal_sim()更新持仓 - 批量处理:成交回报按批次处理,减少锁开销

- 并行更新:不同账户并行更新,提高吞吐量

- towards转换:从 direction+offset 转换为 qars 的 towards 值

组件 3: 行情系统 (MarketDataCore)

独立进程,零拷贝广播

#![allow(unused)] fn main() { // src/market/core/mod.rs pub struct MarketDataCore { // iceoryx2 订单簿订阅器 orderbook_subscriber: iceoryx2::Subscriber<OrderbookSnapshot>, // qadataswap 广播器 broadcaster: DataBroadcaster, // 订阅管理 subscriptions: DashMap<String, Vec<String>>, // user_id -> instruments } impl MarketDataCore { pub fn run(&mut self) { loop { // 1. 接收订单簿快照(零拷贝) if let Some(snapshot) = self.orderbook_subscriber.take() { // 2. 广播给所有订阅者(零拷贝) self.broadcaster.publish( &snapshot.instrument_id, MarketDataType::Level2, &snapshot.data ); } } } } }

组件 4: 交易网关 (Gateway)

独立线程,订单路由与风控

#![allow(unused)] fn main() { // examples/high_performance_demo.rs - Gateway 线程 let gateway_handle = { let account_sys = account_system.clone(); let order_sender = order_tx.clone(); thread::Builder::new() .name("Gateway".to_string()) .spawn(move || { while let Ok(mut order_req) = client_rx.recv() { // 1. 提取用户信息 let user_id = std::str::from_utf8(&order_req.user_id) .unwrap_or("") .trim_end_matches('\0') .to_string(); let instrument_id = std::str::from_utf8(&order_req.instrument_id) .unwrap_or("") .trim_end_matches('\0'); // 2. 先通过账户系统 send_order() // 这是关键!必须先经过账户系统: // - 生成 order_id (UUID) // - 校验资金/保证金 // - 冻结资金 // - 记录到 dailyorders if let Some(account) = account_sys.get_account(&user_id) { let mut acc = account.write(); // 计算 towards(direction + offset → towards) let towards = if order_req.direction == 0 { if order_req.offset == 0 { 1 } else { 3 } // BUY OPEN=1, BUY CLOSE=3 } else { if order_req.offset == 0 { -2 } else { -3 } // SELL OPEN=-2, SELL CLOSE=-3 }; let datetime = chrono::Utc::now().format("%Y-%m-%d %H:%M:%S").to_string(); // 关键:调用 send_order() 进行风控校验和资金冻结 match acc.send_order( instrument_id, order_req.volume, &datetime, towards, order_req.price, "", "LIMIT", ) { Ok(qars_order) => { // 3. 获取账户生成的 order_id let account_order_id = qars_order.order_id.clone(); // 4. 将 order_id 写入 OrderRequest(用于撮合引擎和回报匹配) let order_id_bytes = account_order_id.as_bytes(); let len = order_id_bytes.len().min(40); order_req.order_id[..len].copy_from_slice(&order_id_bytes[..len]); log::info!("[Gateway] {} 订单已创建: {} (冻结资金完成)", user_id, account_order_id); // 5. 发送到撮合引擎 let _ = order_sender.send(order_req); } Err(e) => { log::error!("[Gateway] {} 订单被拒绝: {:?}", user_id, e); } } } } }) .unwrap() }; }

关键点:

- 订单必须先经过 AccountSystem.send_order():这是架构的核心原则!

- 生成 order_id:由账户系统生成,不是由撮合引擎生成

- 风控前置:资金校验、保证金检查、仓位检查都在 send_order() 中完成

- 资金冻结:开仓时立即冻结保证金,防止超额下单

- Towards 转换:将 direction+offset 转换为 qars 的 towards 值

- 拒绝处理:资金不足、仓位不足等风控失败时,订单不会进入撮合引擎

两层订单ID设计(真实交易所架构)

为什么需要两层ID?

问题:如果只用一个ID,会导致:

- 账户系统生成ID:全局可能重复(多账户可能生成相同UUID)

- 交易所生成ID:账户系统无法匹配回原始订单

解决方案:两层ID设计

order_id:账户系统生成(UUID格式,40字节),用于账户内部匹配dailyordersexchange_order_id:交易所生成,全局唯一(单日不重复),用于行情推送

完整流程(Sim模式,8步)

┌─────────┐

│ Client │

└────┬────┘

│ 1. 发送订单请求(OrderRequest)

│ direction: BUY(0)/SELL(1)

│ offset: OPEN(0)/CLOSE(1)

↓

┌──────────────────────────────────────────────────────────┐

│ Gateway (订单路由线程) │

│ │

│ 2. 调用 AccountSystem.send_order() │

│ ✓ 生成 order_id (UUID): "a1b2c3d4-e5f6-..." │

│ ✓ 计算 towards 值 (direction + offset → towards) │

│ ✓ 校验资金/保证金 │

│ ✓ 冻结资金 (frozen += margin_required) │

│ ✓ 记录到 dailyorders (status="PENDING") │

│ │

│ 3. 将 order_id 写入 OrderRequest.order_id[40] │

│ 转发到 MatchingEngine │

└──────────────────┬───────────────────────────────────────┘

│

↓

┌──────────────────────────────────────────────────────────┐

│ MatchingEngine (撮合引擎线程) │

│ │

│ 4. 订单进入订单簿 (Success::Accepted) │

│ ✓ 生成 exchange_order_id (全局唯一) │

│ 格式: "EX_{timestamp}_{code}_{direction}" │

│ 示例: "EX_1728123456789_IX2401_B" │

│ │

│ 5. 发送 OrderAccepted 消息 │

│ order_id: "a1b2c3d4-e5f6-..." │

│ exchange_order_id: "EX_1728123456789_IX2401_B" │

└──────────────────┬───────────────────────────────────────┘

│

↓

┌──────────────────────────────────────────────────────────┐

│ AccountSystem (账户系统线程) │

│ │

│ 6. 接收 OrderAccepted → on_order_confirm() │

│ ✓ 根据 order_id 查找 dailyorders │

│ ✓ 更新 order.exchange_order_id │

│ ✓ 更新 order.status = "ALIVE" │

└───────────────────────────────────────────────────────────┘

│

│ (撮合成交)

↓

┌──────────────────────────────────────────────────────────┐

│ MatchingEngine (撮合引擎线程) │

│ │

│ 7. 撮合成功 → 发送 TradeReport │

│ trade_id: "TRADE_123456" │

│ order_id: "a1b2c3d4-e5f6-..." (用于匹配账户) │

│ exchange_order_id: "EX_..." (用于行情推送) │

└──────────────────┬───────────────────────────────────────┘

│

↓

┌──────────────────────────────────────────────────────────┐

│ AccountSystem (账户系统线程) │

│ │

│ 8. 接收 TradeReport → receive_deal_sim() │

│ ✓ 根据 order_id 匹配 dailyorders │

│ ✓ 更新持仓 (volume_long/volume_short) │

│ ✓ 释放冻结保证金 (frozen -= margin) │

│ ✓ 占用实际保证金 (margin += actual_margin) │

│ ✓ 更新 order.status = "FILLED" │

└───────────────────────────────────────────────────────────┘

│

↓

┌──────────────────┐

│ MarketData │ 使用 exchange_order_id 推送逐笔成交

│ (行情推送) │ (保护用户隐私,不暴露UUID)

└──────────────────┘

Towards值系统(期货交易)

qaexchange-rs 使用 QARS 的 towards 参数统一表示方向+开平:

| Direction | Offset | Towards | 含义 |

|---|---|---|---|

| BUY (0) | OPEN (0) | 1 | 买入开仓(开多) |

| SELL (1) | OPEN (0) | -2 | 卖出开仓(开空) |

| BUY (0) | CLOSE (1) | 3 | 买入平仓(平空头) |

| SELL (1) | CLOSE (1) | -3 | 卖出平仓(平多头) |

注意:SELL OPEN 使用 -2 而非 -1,因为 -1 在QARS中表示 "SELL CLOSE yesterday"(只平昨日多头)。

转换代码示例:

#![allow(unused)] fn main() { let towards = if order_req.direction == 0 { if order_req.offset == 0 { 1 } else { 3 } // BUY OPEN=1, BUY CLOSE=3 } else { if order_req.offset == 0 { -2 } else { -3 } // SELL OPEN=-2, SELL CLOSE=-3 }; }

详细说明请参考:期货交易机制详解

数据结构定义(零拷贝)

#![allow(unused)] fn main() { // src/protocol/ipc_messages.rs use serde_big_array::BigArray; #[repr(C)] #[derive(Clone, Copy, Serialize, Deserialize)] pub struct OrderRequest { #[serde(with = "BigArray")] pub order_id: [u8; 40], // 账户订单ID(UUID 36字符+填充) pub user_id: [u8; 32], pub instrument_id: [u8; 16], pub direction: u8, // 0=BUY, 1=SELL pub offset: u8, // 0=OPEN, 1=CLOSE pub price: f64, pub volume: f64, pub timestamp: i64, pub gateway_id: u32, pub session_id: u32, } #[repr(C)] #[derive(Clone, Copy, Serialize, Deserialize)] pub struct OrderAccepted { #[serde(with = "BigArray")] pub order_id: [u8; 40], // 账户订单ID(用于匹配 dailyorders) pub exchange_order_id: [u8; 32], // 交易所订单ID(全局唯一) pub user_id: [u8; 32], pub instrument_id: [u8; 16], pub timestamp: i64, pub gateway_id: u32, pub session_id: u32, } #[repr(C)] #[derive(Clone, Copy, Serialize, Deserialize)] pub struct TradeReport { pub trade_id: [u8; 32], // 成交ID(交易所生成,全局唯一) #[serde(with = "BigArray")] pub order_id: [u8; 40], // 账户订单ID(用于匹配 dailyorders) pub exchange_order_id: [u8; 32], // 交易所订单ID(全局唯一,用于行情推送) pub user_id: [u8; 32], pub instrument_id: [u8; 16], pub direction: u8, pub offset: u8, pub price: f64, pub volume: f64, pub timestamp: i64, pub commission: f64, } #[repr(C)] #[derive(Clone, Copy, Serialize, Deserialize)] pub struct OrderbookSnapshot { pub instrument_id: [u8; 16], pub timestamp: i64, pub bids: [PriceLevel; 10], pub asks: [PriceLevel; 10], } #[repr(C)] #[derive(Clone, Copy, Serialize, Deserialize)] pub struct PriceLevel { pub price: f64, pub volume: f64, pub order_count: u32, } }

关键点:

#[repr(C)]保证内存布局稳定- 固定大小,无需动态分配

- 可直接放入共享内存(iceoryx2)

- order_id 使用40字节:UUID是36字符,需要额外空间存储字符串结束符

- serde-big-array:Serde默认只支持32字节以下数组,超过需要

#[serde(with = "BigArray")]

UUID截断问题的解决

问题:标准UUID是36字符(如 a1b2c3d4-e5f6-7890-abcd-1234567890ab),如果使用32字节数组会被截断。

解决方案:

#![allow(unused)] fn main() { // Cargo.toml 添加依赖 serde-big-array = "0.5" // 扩展数组大小 pub order_id: [u8; 40] // 36 + 终止符 + 对齐 // 写入时确保长度正确 let order_id_bytes = account_order_id.as_bytes(); let len = order_id_bytes.len().min(40); order_req.order_id[..len].copy_from_slice(&order_id_bytes[..len]); // 读取时正确处理 let order_id = std::str::from_utf8(&trade.order_id) .unwrap_or("") .trim_end_matches('\0'); // 移除填充的空字符 }

部署架构

┌─────────────────────────────────────────────────────────┐

│ Process Topology │

└─────────────────────────────────────────────────────────┘

┌──────────────┐ ┌──────────────┐ ┌──────────────┐

│ Gateway-1 │ │ Gateway-2 │ │ Gateway-N │

│ (Port 8080) │ │ (Port 8081) │ │ (Port 808N) │

└──────┬───────┘ └──────┬───────┘ └──────┬───────┘

│ │ │

└────────────┬────┴─────────────────┘

│ iceoryx2

↓

┌────────────────────────────┐

│ MatchingEngineCore │

│ (Single Process) │

│ ┌────────┐ ┌────────┐ │

│ │ IX2401 │ │ IF2401 │ │

│ └────────┘ └────────┘ │

└────────┬───────────────────┘

│ iceoryx2

┌────────┴───────────┐

↓ ↓

┌──────────────┐ ┌──────────────┐

│ AccountCore │ │ MarketCore │

│ (Sharded) │ │ │

└──────────────┘ └──────────────┘

性能优化策略

1. 撮合引擎优化

#![allow(unused)] fn main() { // 使用 SPSC 队列(单生产者单消费者) use crossbeam::queue::ArrayQueue; pub struct OptimizedOrderbook { // 预分配价格档位 price_levels: Vec<PriceLevel>, // 无锁订单队列 pending_orders: ArrayQueue<OrderRequest>, // CPU 亲和性绑定 cpu_affinity: usize, } }

2. 账户系统优化

#![allow(unused)] fn main() { // 账户分片(减少锁竞争) pub struct ShardedAccountSystem { shards: Vec<AccountSystemCore>, shard_count: usize, } impl ShardedAccountSystem { fn get_shard(&self, user_id: &str) -> usize { // 哈希分片 let hash = hash(user_id); hash % self.shard_count } } }

3. 行情推送优化

#![allow(unused)] fn main() { // 使用 qadataswap 的零拷贝广播 let broadcaster = DataBroadcaster::new(BroadcastConfig { topic: "market_data", buffer_size: 1024 * 1024, // 1MB subscriber_capacity: 10000, }); }

监控指标

#![allow(unused)] fn main() { pub struct ExchangeMetrics { // 撮合延迟分布 matching_latency_p50: Histogram, matching_latency_p99: Histogram, // 订单吞吐 order_throughput: Counter, // 成交吞吐 trade_throughput: Counter, // 账户更新延迟 account_update_latency: Histogram, // 行情推送延迟 market_publish_latency: Histogram, } }

容错设计

- 撮合引擎:单点故障 → 主备切换(Raft)

- 账户系统:定期快照 + WAL 日志

- 行情系统:无状态,可随时重启

- 网关:无状态,可水平扩展

核心架构原则总结

1. 订单必须先经过账户系统(关键!)

这是整个架构的核心原则,参考真实交易所(上交所、中金所、CTP等)的设计:

❌ 错误流程(会导致崩溃):

Client → Gateway → MatchingEngine → AccountSystem

↓

订单直接进入撮合

↓

TradeReport 返回

↓

AccountSystem.receive_deal_sim()

↓

💥 NOT IN DAY ORDER 错误!

(因为 dailyorders 中没有这个订单)

✅ 正确流程:

Client → Gateway → AccountSystem.send_order()

↓

生成 order_id, 冻结资金, 记录 dailyorders

↓

MatchingEngine(携带 order_id)

↓

OrderAccepted → AccountSystem.on_order_confirm()

↓

TradeReport → AccountSystem.receive_deal_sim()

↓

✅ 成功更新持仓(order_id 匹配成功)

2. 两层ID设计原因

| ID类型 | 生成时机 | 格式 | 用途 |

|---|---|---|---|

| order_id | Gateway调用send_order()时 | UUID(36字符) | 账户内部匹配dailyorders |

| exchange_order_id | MatchingEngine接受订单时 | EX_{ts}{code}{dir} | 全局唯一,行情推送 |

为什么不能只用一个ID?

- 只用 order_id:撮合引擎无法保证全局唯一性(多账户可能生成相同UUID)

- 只用 exchange_order_id:账户系统无法匹配回 dailyorders(因为send_order时还没有这个ID)

3. Sim模式三阶段流程

阶段1: send_order()

✓ 生成 order_id (UUID)

✓ 校验资金/保证金

✓ 冻结资金 (frozen += margin)

✓ 记录到 dailyorders (status="PENDING")

阶段2: on_order_confirm()

✓ 更新 order.exchange_order_id

✓ 更新 order.status = "ALIVE"

阶段3: receive_deal_sim()

✓ 更新持仓 (volume_long/short)

✓ 释放冻结 (frozen -= margin)

✓ 占用保证金 (margin += actual_margin)

✓ 更新 order.status = "FILLED"

关键:Real模式也需要 on_order_confirm(),只是成交处理用 receive_simpledeal_transaction()

4. Towards值系统(期货特有)

#![allow(unused)] fn main() { // 标准映射(qaexchange-rs) BUY OPEN → 1 // 开多 SELL OPEN → -2 // 开空(注意:不是-1!) BUY CLOSE → 3 // 平空 SELL CLOSE → -3 // 平多 // 为什么 SELL OPEN 是 -2 而不是 -1? // -1 在 QARS 中表示 "SELL CLOSE yesterday"(只平昨日多头) // -2 才是标准的卖出开仓(建立空头持仓) }

5. UUID截断问题的解决

问题:UUID是36字符,但32字节数组会截断

原始UUID: a1b2c3d4-e5f6-7890-abcd-1234567890ab (36字符)

32字节截断: a1b2c3d4-e5f6-7890-abcd-5c4b797a (丢失12字符)

解决方案:

- 扩展数组到40字节:

pub order_id: [u8; 40] - 添加依赖:

serde-big-array = "0.5" - 添加属性:

#[serde(with = "BigArray")]

6. 通道复用(crossbeam::select)

AccountSystem 需要同时监听两个通道:

#![allow(unused)] fn main() { select! { recv(accepted_receiver) -> msg => { // 订单确认 → on_order_confirm() } recv(trade_receiver) -> msg => { // 成交回报 → receive_deal_sim() } default(Duration::from_millis(10)) => { // 超时处理批量队列 } } }

7. 批量处理策略

#![allow(unused)] fn main() { // 成交回报按账户分组 → 并行更新 grouped.par_iter().for_each(|(user_id, trades)| { // 每个账户独立锁,减少锁竞争 if let Some(account) = self.accounts.get(user_id) { let mut acc = account.write(); for trade in trades { acc.receive_deal_sim(/* ... */); } } }); }

已完成的P4阶段改进

✅ P4.1: 两层ID设计

- 扩展 order_id 到40字节(支持完整UUID)

- 添加 exchange_order_id 字段

- MatchingEngine 生成全局唯一ID

- serde-big-array 支持

✅ P4.2: Sim模式完整流程

- 新增 OrderAccepted 消息类型

- 新增 accepted_sender/receiver 通道

- 实现 on_order_confirm() 调用

- AccountSystemCore 使用 select! 监听多通道

✅ P4.3: Gateway订单路由

- Gateway 先调用 AccountSystem.send_order()

- 风控前置(资金校验、保证金冻结)

- Towards 值转换(direction+offset → towards)

- order_id 传递到撮合引擎

✅ P4.4: Towards值修正

- BUY OPEN = 1(不是2)

- SELL OPEN = -2(不是-1)

- 所有示例代码更新

✅ P4.5: 文档完善

- 创建 TRADING_MECHANISM.md(期货交易机制详解)

- 更新 HIGH_PERFORMANCE_ARCHITECTURE.md(完整流程)

- 更新 P1_P2_IMPLEMENTATION_SUMMARY.md(P4章节)

下一步实现计划(P5阶段)

Phase 5.1: iceoryx2 零拷贝通信

- 替换 crossbeam::channel 为 iceoryx2

- 定义共享内存服务配置

- 实现 Publisher/Subscriber 模式

Phase 5.2: 性能优化

- CPU 亲和性绑定(撮合引擎固定到核心0)

- 预分配内存池(订单、成交回报)

- 无锁数据结构(SPSC队列)

Phase 5.3: 账户分片

- 按 user_id 哈希分片

- 减少单个 AccountSystem 的锁竞争

- 支持水平扩展

Phase 5.4: 监控与容错

- Prometheus 指标导出

- 撮合引擎主备切换(Raft)

- WAL 日志(账户状态持久化)

Phase 5.5: 性能基准测试

- 执行 benchmark_million_orders.rs

- 测量撮合延迟(P50/P99/P999)

- 测量订单吞吐量

- 对比集中式 vs 分布式架构

Actix Actor 架构

架构作者: @yutiansut @quantaxis 最后更新: 2025-10-07

概述

QAExchange 采用 Actix Actor 模型 实现高并发、低延迟的异步消息处理架构。Actor 模型通过消息传递隔离状态,避免共享内存锁竞争,实现系统的高性能和可扩展性。

Actor 架构总览

系统中的 Actor 实例

QAExchange 系统包含以下 3 类核心 Actor:

| Actor 类型 | 实例数量 | 职责 | 生命周期 |

|---|---|---|---|

| KLineActor | 1 | K线实时聚合、历史查询、WAL持久化 | 系统启动时创建,运行至系统关闭 |

| WsSession | N (每个WebSocket连接1个) | WebSocket会话管理、消息路由 | 连接建立时创建,连接断开时销毁 |

| DiffWebsocketSession | N (每个DIFF协议连接1个) | DIFF协议处理、业务截面同步 | 连接建立时创建,连接断开时销毁 |

架构分层

┌────────────────────────────────────────────────────────────────┐

│ 应用层 (Client) │

│ WebSocket / HTTP 客户端 │

└────────────────────────────────────────────────────────────────┘

▲

│ WebSocket / JSON

▼

┌────────────────────────────────────────────────────────────────┐

│ Actor 层 (Actix Actors) │

│ │

│ ┌─────────────┐ ┌──────────────────┐ ┌──────────────────┐ │

│ │ KLineActor │ │ WsSession │ │ DiffWebsocket │ │

│ │ │ │ (N instances) │ │ Session │ │

│ │ - 订阅tick │ │ - 消息路由 │ │ (N instances) │ │

│ │ - 聚合K线 │ │ - 心跳管理 │ │ - peek_message │ │

│ │ - WAL持久化│ │ - 订阅通知 │ │ - rtn_data │ │

│ │ - 历史查询 │ │ │ │ - 业务截面管理 │ │

│ └─────────────┘ └──────────────────┘ └──────────────────┘ │

│ ▲ ▲ ▲ │

│ │ │ │ │

└─────────┼────────────────┼──────────────────────┼───────────────┘

│ │ │

│ crossbeam │ crossbeam │

│ channel │ channel │

▼ ▼ ▼

┌────────────────────────────────────────────────────────────────┐

│ 消息总线层 (Message Bus) │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ MarketDataBroadcaster (Pub/Sub) │ │

│ │ │ │

│ │ - tick 事件 (Tick价格、成交量) │ │

│ │ - kline_finished (完成的K线) │ │

│ │ - orderbook_update (订单簿快照/增量) │ │

│ │ - trade_executed (成交通知) │ │

│ └─────────────────────────────────────────────────────────┘ │

│ │

│ ┌─────────────────────────────────────────────────────────┐ │

│ │ TradeGateway (Point-to-Point) │ │

│ │ │ │

│ │ - 订单回报 (OrderAccepted/Rejected) │ │

│ │ - 成交通知 (TradeNotification) │ │

│ │ - 账户更新 (AccountUpdate) │ │

│ └─────────────────────────────────────────────────────────┘ │